Website-Auditor SEO Spider: Leistungsstarker Website-Crawler für schnelles Audit

Geben Sie Ihre E-Mail-Adresse ein, um den

Download zu starten. Wir senden Ihnen auch die Download-Links per E-Mail zu.

Site-Audits sind keine Herausforderung mehr.

- Blitzschnelles Site-Audit

- Alle Ressourcen überprüft: JavaScript, CSS, Bilder, Videos usw. crawlen.

- Crawling wie Google, Bing oder Yandex

- Benutzerdefinierte Extraktion beliebiger Inhalte

- Planung von SEO-Audits und Berichterstattung an Kunden

Das Website Auditor SEO Spider-Tool umfasst alles, was man von einer Crawling-Software

erwarten kann: Scraping dynamisch generierter Inhalte und passwortgeschützter Websites,

Identifizierung von Weiterleitungsketten, defekten Links und technischen Fehlern; B. die Prüfung

von Onsite-SEO und Verlinkungsfaktoren, die Suche nach beliebigen Inhalten auf der gesamten

Website usw. Aber was noch wichtiger ist: Es ermöglicht Ihnen, jede Website umfassend zu sehen,

genau wie Suchmaschinen – unabhängig davon, worauf sie aufbaut, wie groß sie ist oder welche

SEO-Faktoren, die Sie messen möchten.

Schnelles und umfassendes SEO-Audit.

Das WebSite Auditor SEO Spider-Tool durchsucht Ihre

Website genau wie Suchmaschinen-Bots, lässt kein Tag unversucht und hilft Ihnen, Probleme in allen Arten von

Ressourcen Ihrer Website zu erkennen. Es durchsucht nicht nur HTML, sondern auch CSS, JavaScript, Flash,

Bilder, Videos, PDFs und andere interne und externe Ressourcen.

1

Crawlen Sie Websites mit allen ihren Subdomains.

Wenn Ihre Site Subdomains und Verzeichnisse

enthält, können Sie diese mit dem WebSite Auditor bequem zusammen mit Ihrer Hauptdomain crawlen, sodass Sie

alle Ihre Seiten und Ressourcen – und Ihre Site-Struktur als Ganzes – in einem einzigen Projekt prüfen und

analysieren können.

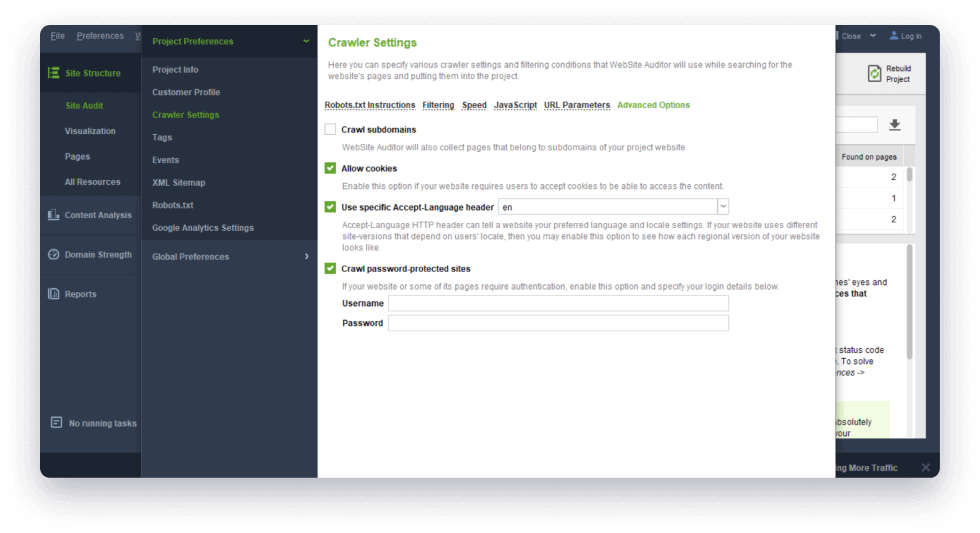

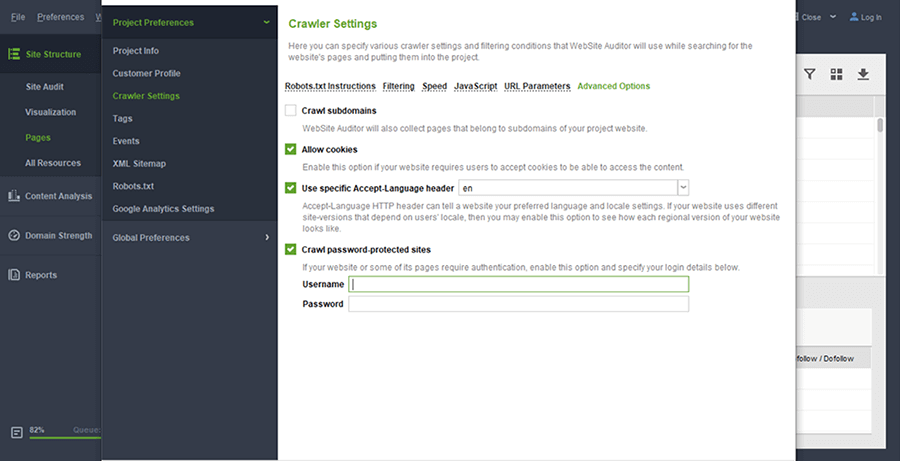

Wo Sie es finden: Wenn Sie ein neues

Projekt erstellen, aktivieren Sie in Schritt 1 das Kontrollkästchen „Expertenoptionen

anzeigen“, gehen Sie zu „Erweiterte Optionen“ und aktivieren Sie das Kontrollkästchen

„Subdomains crawlen “. Gehen Sie für ein vorhandenes Projekt zu „Einstellungen“ >

„Crawler-Einstellungen“, um dasselbe zu tun, und klicken Sie auf „Projekt neu

erstellen“.

2

Crawlen Sie passwortgeschützte Websites.

Das Tool ermöglicht das Crawlen und Prüfen von Websites, die eine Authentifizierung

erfordern, und optimiert passwortgeschützte Seiten.

Wo Sie es finden: Wenn Sie ein neues

Projekt erstellen, aktivieren Sie in Schritt 1 das Kontrollkästchen „Expertenoptionen anzeigen“

und wählen Sie einen Bot aus. Gehen Sie für ein vorhandenes Projekt zu „Einstellungen“ >

„Crawler-Einstellungen“, um dasselbe zu tun, und klicken Sie auf „Projekt neu

erstellen“.

3

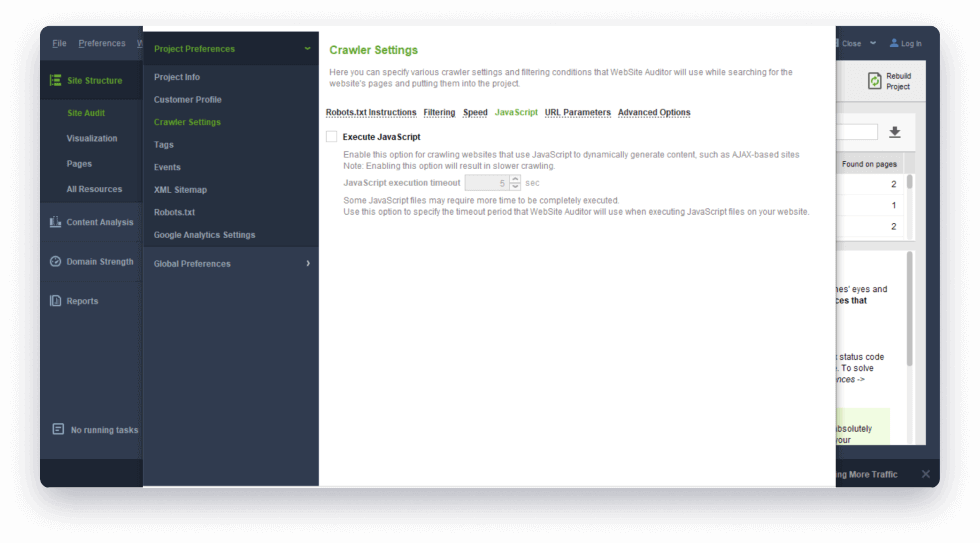

Crawlen Sie JavaScript-Websites und dynamisch generierte Inhalte.

Der WebSite Auditor SEO Spider kann JavaScript

ausführen und dynamisch generierte Inhalte crawlen, um Webseiten vollständig darzustellen, einschließlich

Text und Links.

Wo Sie es finden: Wenn Sie ein Projekt

erstellen, aktivieren Sie in Schritt 1 das Kontrollkästchen „Expertenoptionen anzeigen“, gehen

Sie zu „Erweiterte Optionen“ und aktivieren Sie „JavaScript ausführen“. Gehen Sie für

ein vorhandenes Projekt zu „Einstellungen“ > „Crawler-Einstellungen“, um dasselbe zu tun,

und klicken Sie auf „Projekt neu erstellen“.

4

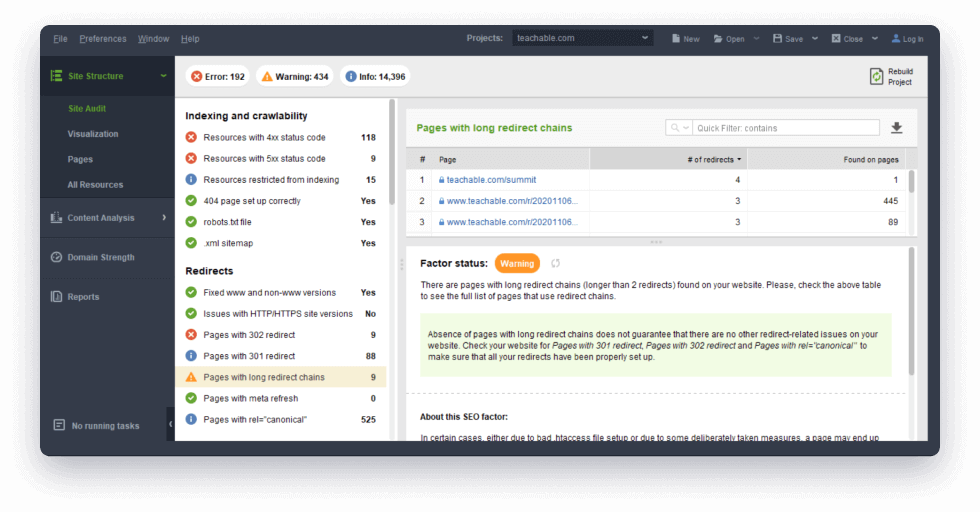

Identifizieren Sie Weiterleitungsketten.

Scannen Sie URLs, um zu analysieren, ob auf der

Website Weiterleitungsketten vorhanden sind. Sie sehen eine Liste der Seiten, von denen die Weiterleitungen

stammen, zusammen mit dem vollständigen Weiterleitungspfad – so können Sie schnell erkennen, was wo behoben

werden muss.

Wo Sie es finden: Unter Site-Struktur

> Site-Audit im Abschnitt Weiterleitungen.

5

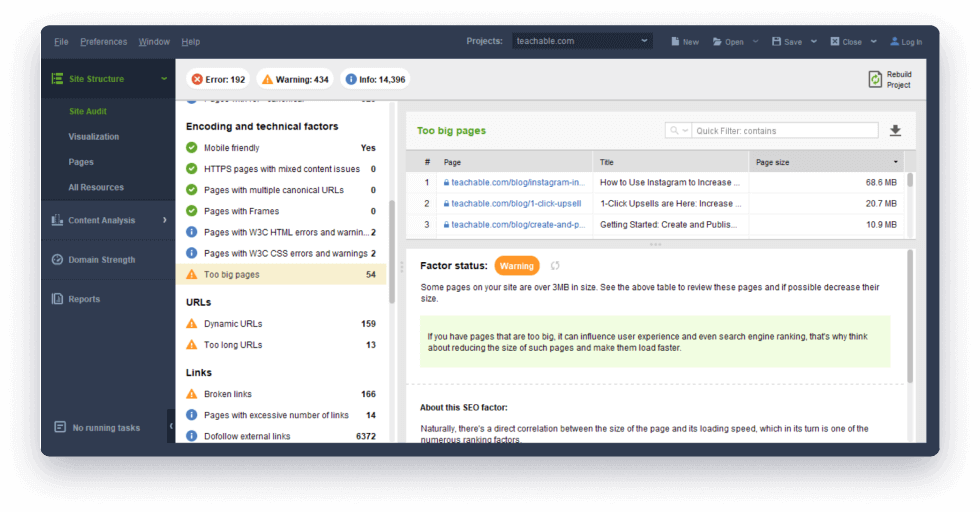

Überprüfen Sie technische SEO-Faktoren, um langsame Seiten zu erkennen.

Der WebSite Auditor SEO Spider erkennt, ob Seiten

für Mobilgeräte geeignet oder wahrscheinlich zu groß sind und sich negativ auf den SEO-Score und die

Benutzererfahrung auswirken können. Die Seitengröße wird umfassend berechnet, indem die Größe des HTML-Codes

mit der Größe aller auf der Seite verwendeten Ressourcen, einschließlich Bildern, Videos und JavaScript,

addiert wird. Das Tool prüft, ob eine Ihrer Seiten eine Geschwindigkeitsoptimierung vertragen könnte. Eine

Liste solcher URLs finden Sie direkt im Site Audit-Dashboard zusammen mit der Größe jeder Seite in Megabyte.

Wo Sie es finden: Unter Site-Struktur

> Site-Audit im Abschnitt Kodierung und technische Faktoren.

6

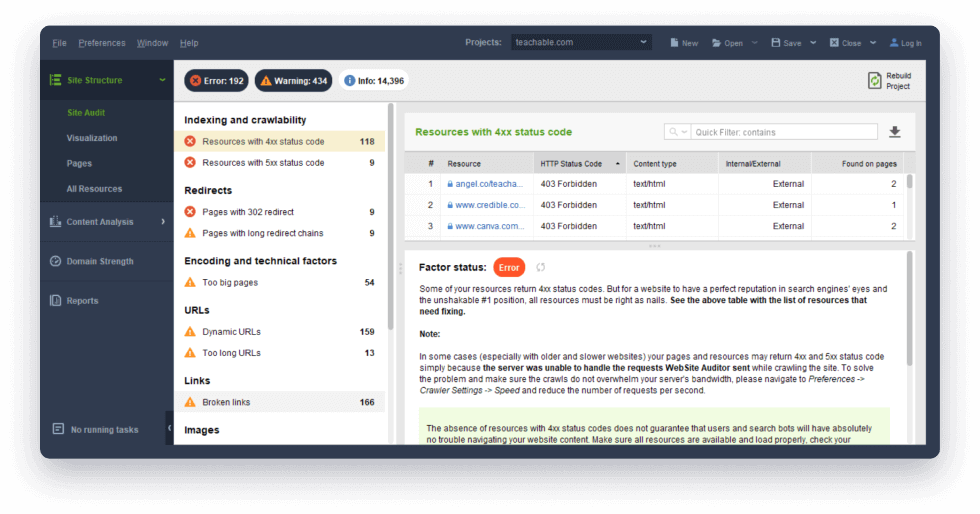

Suchen Sie nach defekten Links und Serverfehlern.

Mit dem Tool SEO Spider finden Sie defekte Links

(Seite 404) und Serverfehler im Handumdrehen. Achten Sie auch auf Seiten mit übermäßig vielen externen

Links, um Suchmaschinensanktionen zu vermeiden.

Wo Sie es finden: Unter „Site-Struktur“

> „Site-Audit“ im Abschnitt „Indizierung und Crawlbarkeit “ und „Links“.

7

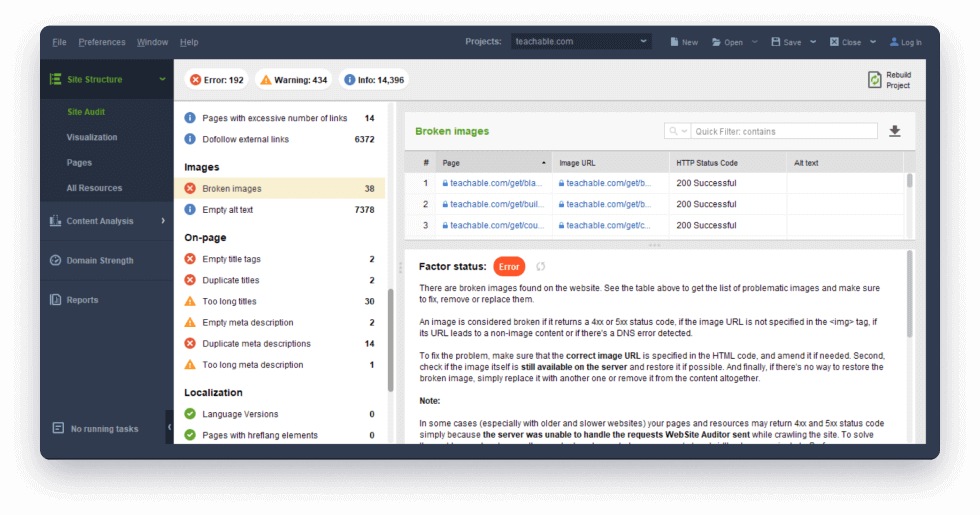

Schnelle Prüfung aller Bilder der Website.

Der WebSite Auditor SEO Spider erkennt, ob einige

davon defekt sind oder leere Alt-Text-Tags haben, und zeigt Ihnen eine Liste der Seiten an, auf denen die

problematischen Bilder gefunden werden.

Wo Sie es finden: Unter Site-Struktur

> Site-Audit im Abschnitt Bilder.

8

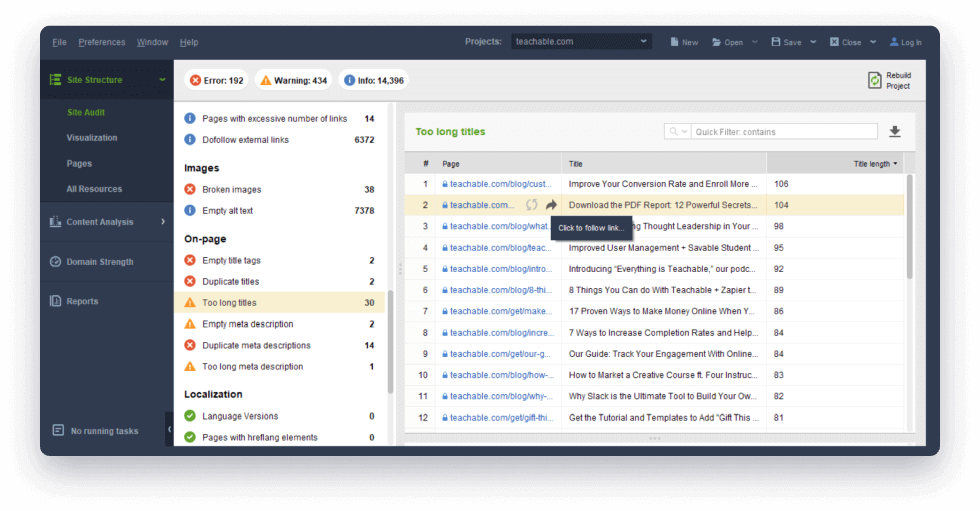

Verbessern Sie die Onsite-SEO.

Finden Sie zu lange Seitentitel, doppelte URLs,

leere oder doppelte Tags und Meta-Beschreibungen. Korrigieren Sie doppelten Inhalt in Seitentiteln.

Wo Sie es finden: Unter Site-Struktur

> Site-Audit im On-Page- Bereich.

9

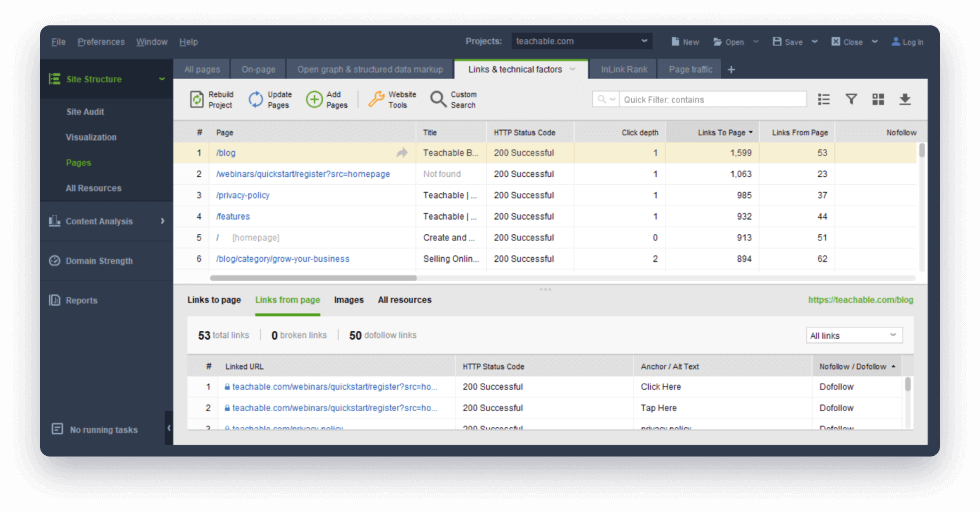

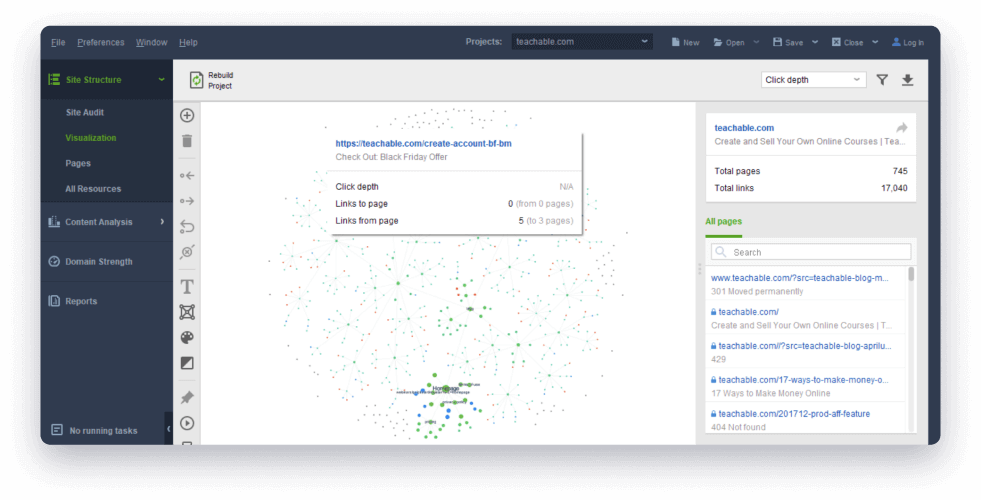

Finden Sie Seiten, die zu tief auf Ihrer Website vergraben sind.

Mithilfe der Metrik „Klicktiefe“ können Sie Seiten

auf Ihrer Website identifizieren, die für Benutzer und Suchmaschinen schwer zu finden sind. Die Klicktiefe

zeigt die Anzahl der Klicks an, die erforderlich sind, um von der Startseite zu einer bestimmten Seite zu

gelangen. Idealerweise sollten alle Seiten mit maximal 4 Klicks zugänglich sein, um die Crawlbarkeit zu

verbessern und einen zu hohen PageRank-Verlust zu vermeiden.

Wo es zu finden ist: Bei neuen Projekten

wird automatisch eine Spalte „Klicktiefe“ zum Arbeitsbereich „Alle Seiten“ (im

Seiten- Dashboard) hinzugefügt. Bei bestehenden Projekten müssen Sie es manuell hinzufügen,

indem Sie mit der rechten Maustaste auf die Kopfzeile einer beliebigen Spalte klicken.

10

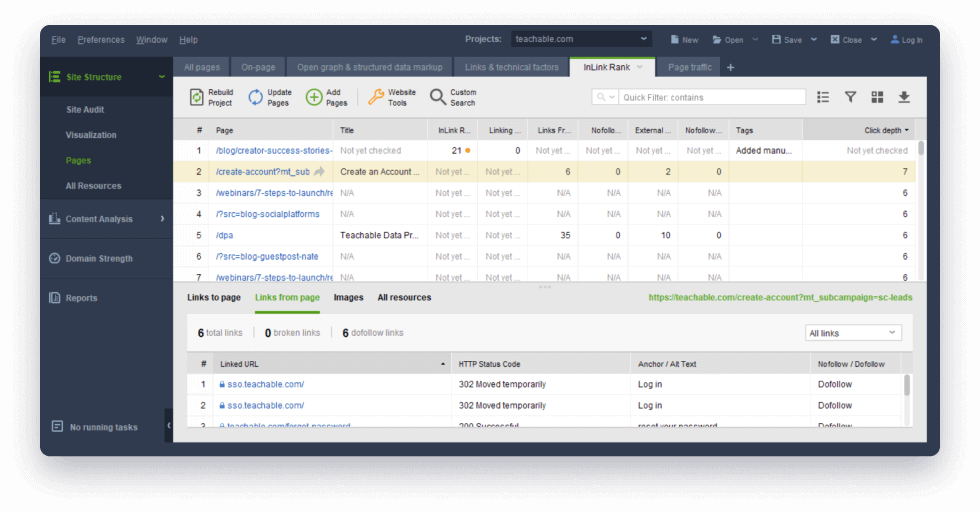

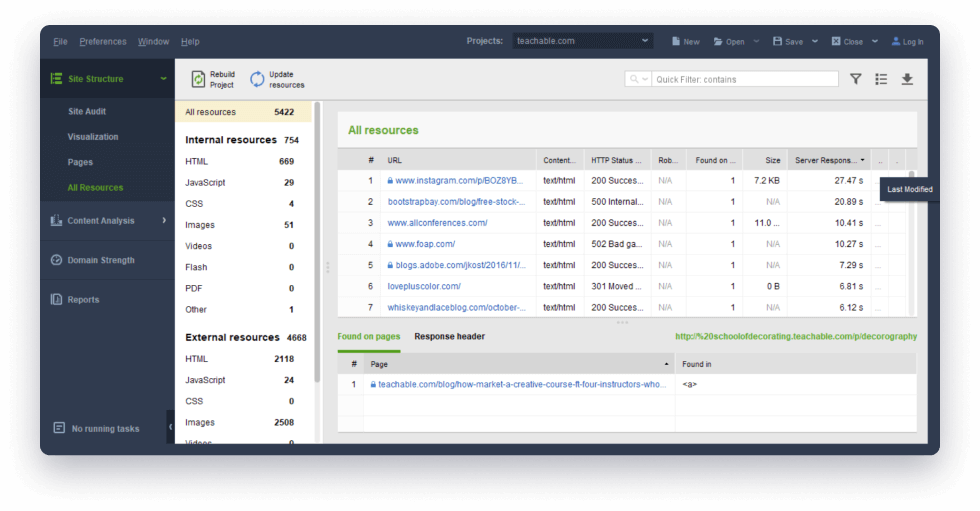

Sehen Sie, wie Ihre Seiten und Ressourcen miteinander verknüpft sind.

Links sind entscheidend für den SEO-Score einer

Website. Sie fragen sich, wie gut die Verlinkung zu einer Seite ist? Untersuchen Sie alle internen und

externen Links zu und von der Seite mit einem Klick.

Wo Sie es finden: Unter Site-Struktur

> Alle Ressourcen und Site-Struktur > Seiten.

11

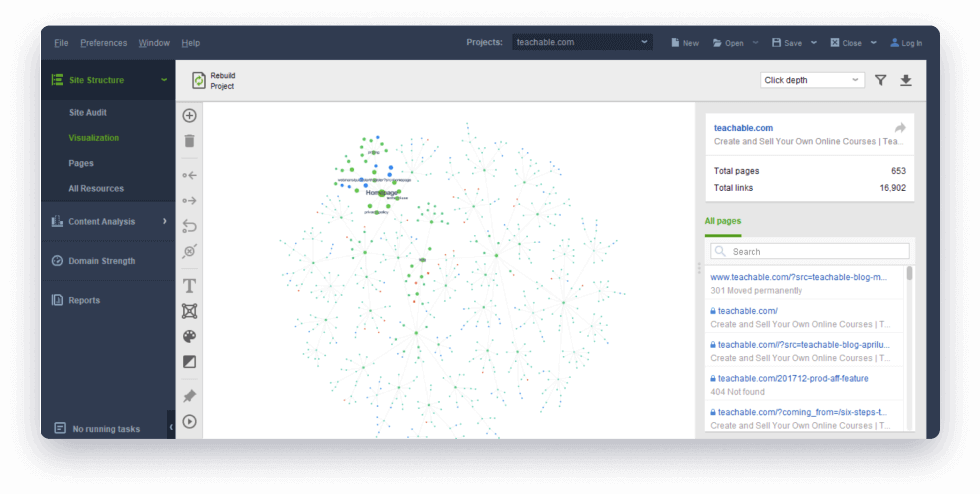

Visualisieren Sie die Site-Architektur.

Das interaktive Visualisierungstool ermöglicht den

Aufbau Ihrer Website-Struktur und die Verknüpfung von Seiten. Aufschlussreiche Diagramme zeigen die

stärksten Seiten sowie diejenigen, die mehr Verbindungen benötigen.

12

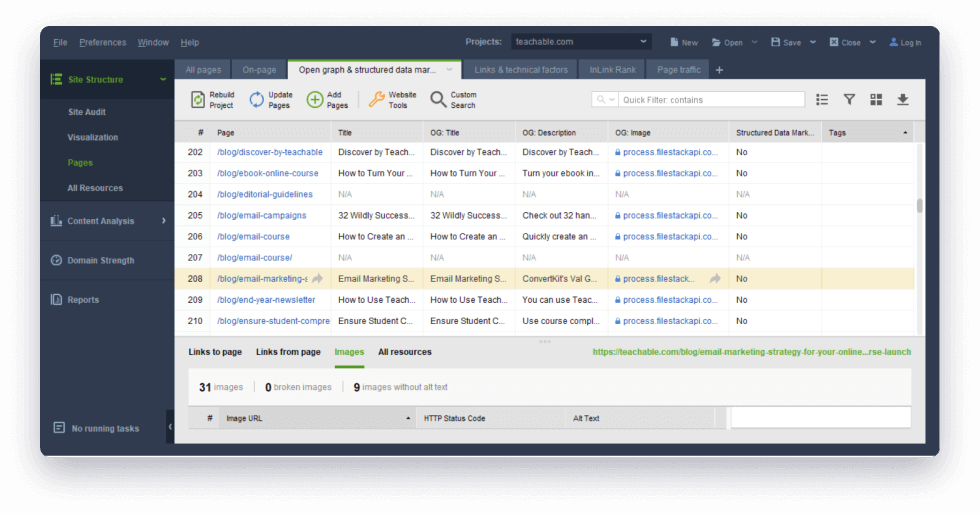

Überprüfen Sie Mikrodaten und Open Graph-Markup.

Sehen Sie, auf welchen Ihrer Seiten keine strukturierten Daten vorhanden sind, sowie das von Google für Knowledge

Graph-Einträge verwendete Markup, Rich Snippets und lokale Ränge. Sie können auch die Open Graph-Titel,

Beschreibungen und Bilder jeder Seite überprüfen – diese Art von Metadaten wird in Snippets verwendet, wenn

Ihre Seiten in sozialen Medien geteilt werden.

Wo Sie es finden: In „Site-Struktur“

> „Seiten“ in den Spalten „Markup für strukturierte Daten“, „OG-Titel“, „OG-Bild“ und

„OG-Beschreibung“.

13

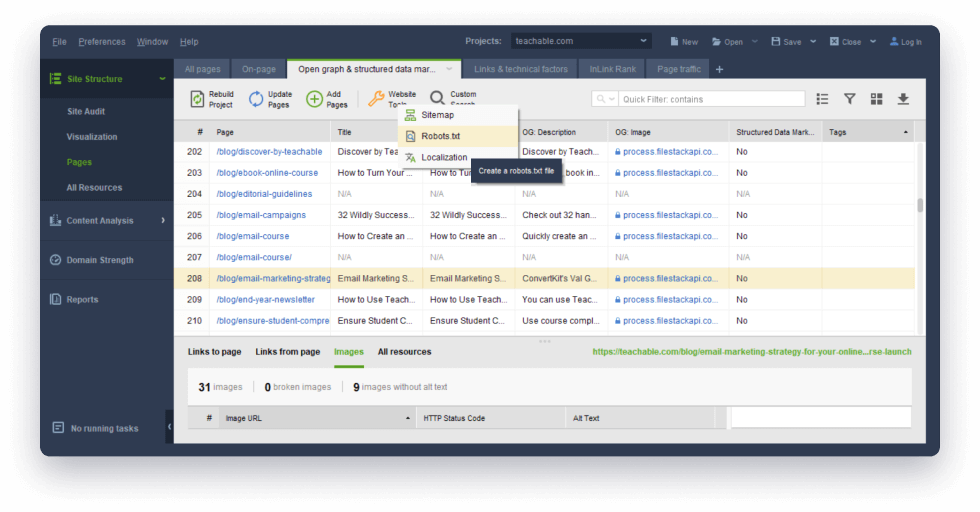

Führen Sie ein Lokalisierungsaudit durch.

Das Website Auditor SEO Spider-Tool analysiert

Ihre lokalisierten Seiten und meldet Probleme mit Hreflang-Elementen. Um Probleme mit doppelten Inhalten zu

vermeiden, verwenden Sie Hreflang-Elemente oder Sitemaps, in denen Sie Google und anderen Suchmaschinen

mitteilen, welche Sprachversion für Benutzer, die andere Sprachen sprechen, besser geladen werden sollte.

14

Generieren Sie XML-Sitemaps und Roboteranweisungen.

Generieren Sie XML-Sitemaps, um Ihre URL-Struktur

für Bots besser zugänglich zu machen. Erstellen Sie robots.txt-Dateien mit Meta-Robots-Anweisungen (wie

„noindex“, „dofollow“, „nofollow“), um Bots anzuweisen, URLs auf Ihrer Website zu scannen. Mit dem Tool

können Sie XML-Sitemaps und Meta-Robots auf Ihrem Computer speichern oder direkt per FTP auf die Website

hochladen.

15

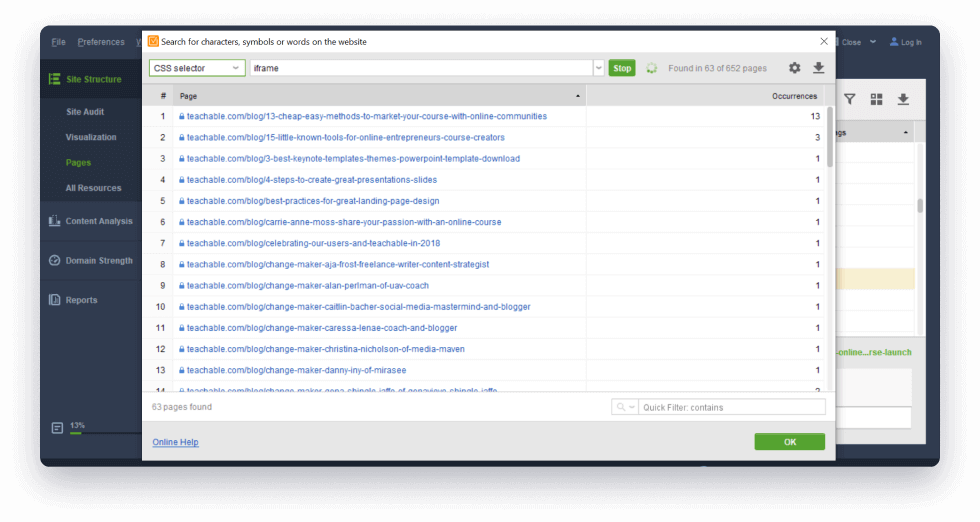

Verwenden Sie die benutzerdefinierte Suche, um beliebige Inhalte auf Ihrer Website abzurufen.

Mit der benutzerdefinierten Suchoption von WebSite

Auditor können Sie alle Instanzen eines beliebigen Inhalts auf einer Website finden – sei es ein HTML-Tag,

ein Skript, ein Plugin oder Schlüsselwörter in Überschriften und Texten. Und wenn Sie Designer oder

Webentwickler sind, werden Sie die CSS-Auswahloption zum Suchen nach bestimmten Elementen mit CSS-Syntax

sicher lieben.

Wo Sie es finden: Unter Site-Struktur

> Seiten > Schaltfläche „Benutzerdefinierte Suche“ in der oberen Menüleiste. Schauen Sie

sich unsere 10 Anwendungsfälle der benutzerdefinierten Suche an.

16

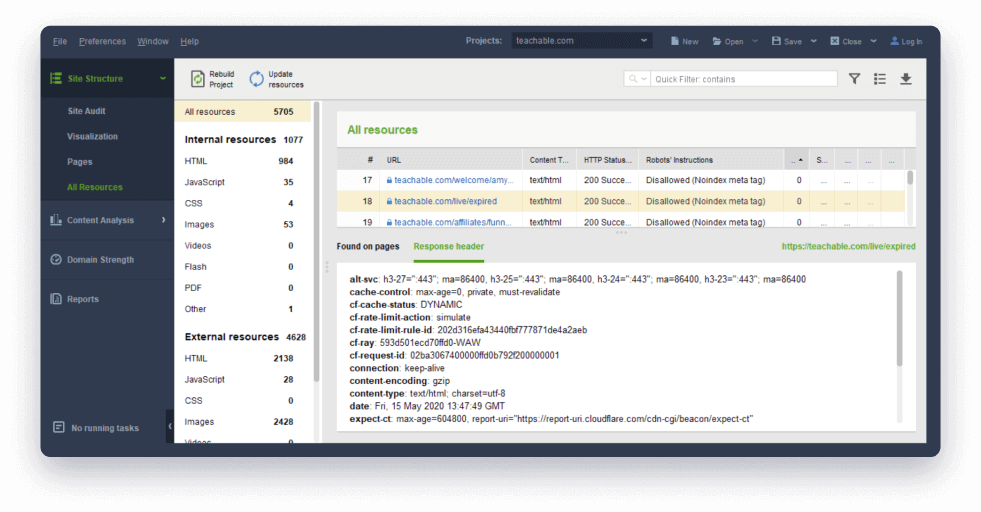

Entdecken Sie versteckte Probleme mit dem Untermodul „Alle Ressourcen“.

Der WebSite Auditor SEO Spider analysiert jedes HTML-Tag und Header-Feld Ihrer Seiten,

um Probleme aufzudecken, die andere Crawler nicht finden würden. Dazu gehört alles von häufigen

HTML-Problemen wie leeren „href“-Attributen für Links oder „src“-Attributen für Bilder bis hin zu den

zahlreichen <link>-Tags (oft automatisch vom CMS erstellt), Iframes, Google Analytics-Skripten und

Social-Media-Sharing-Plugins.

Es dauert nur einen Moment, sicherzustellen, dass Sie alle richtigen Skripte und Elemente auf den

richtigen Seiten haben. Haben Sie eine Seite entdeckt, die zu schwer oder zu langsam ist? Sehen Sie sich

alle darauf verwendeten Ressourcen an, um den Täter zu finden.

Wo Sie es finden: Klicken Sie in der

Site-Struktur > Alle Ressourcen auf eine Ressource und überprüfen Sie die Spalte

„Gefunden in“.

Bereit zum Testen? Wenn Sie den Website Auditor noch nicht installiert

haben, laden

Sie ihn kostenlos herunter und erstellen Sie ein neues Projekt für Ihre Website – es sind nur wenige

Klicks erforderlich.

Viele detaillierte Optionen für technisch versierte Menschen.

Hier sind einige Optimierungen und Anwendungsfälle, die fortgeschrittene SEOs lieben werden.

1

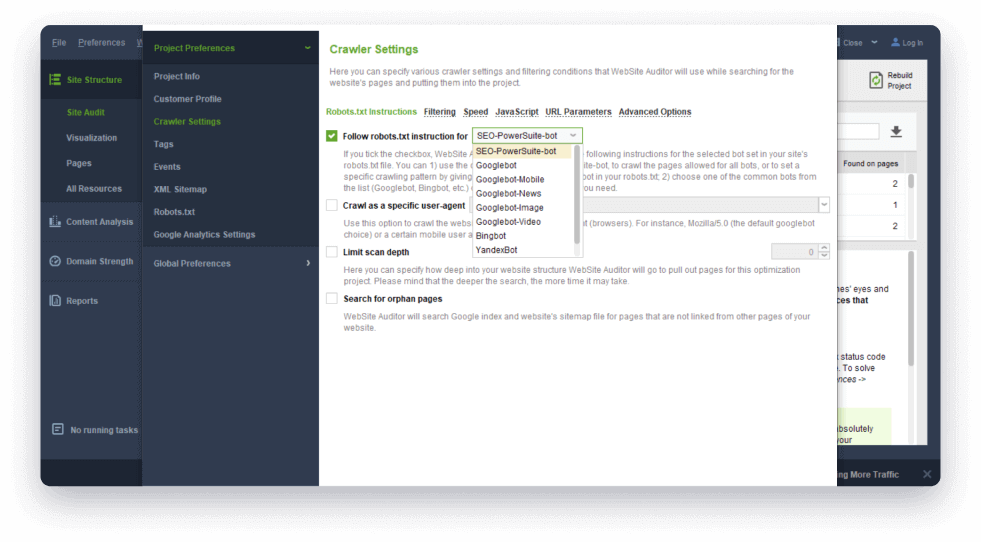

Passen Sie alles an.

Mit dem SEO Spider des webSite Auditors können Sie Ihre Crawl-Konfiguration auf vielfältige Weise anpassen:

- Wählen Sie einen Bot oder Benutzeragenten aus, als den Sie crawlen möchten.

- Kriechgeschwindigkeit anpassen;

- Verwenden Sie Filter, um nur Seiten mit (oder ohne) bestimmten Symbolen in URLs zu crawlen;

- Behandeln Sie Seiten mit bestimmten URL-Parametern als unterschiedliche Seiten (oder als dieselbe Seite) und geben Sie Parameter an, die verwendet oder ignoriert werden sollen.

Letzteres kann besonders nützlich sein, wenn Sie eine CMS-basierte Website prüfen, die häufig zahlreiche Versionen derselben Seite mit unterschiedlichen Parametern erstellt, was Suchmaschinen verwirrt, Duplizierungsprobleme verursacht und Ihr Crawling-Budget verschwendet.

Wo Sie es finden: Unter Einstellungen > Crawler-Einstellungen. Damit Ihre Anpassungen übernommen werden, klicken Sie auf „Projekt neu erstellen“.

2

Sehen Sie Ihre Website wie einen Google-Roboter.

Oder Bings, Yandexs oder andere Bots. Mit dem WebSite Auditor SEO Spider können Sie jede Website anhand der robots.txt-Anweisungen crawlen, entweder für alle Spider oder für einen bestimmten Bot Ihrer Wahl.

Wo Sie es finden: Wenn Sie ein neues Projekt erstellen, aktivieren Sie in Schritt 1 das Kontrollkästchen „Expertenoptionen anzeigen“ und wählen Sie einen Bot aus. Gehen Sie für ein vorhandenes Projekt zu „Einstellungen“ > „Crawler-Einstellungen“, um dasselbe zu tun, und klicken Sie auf „Projekt neu erstellen“.

3

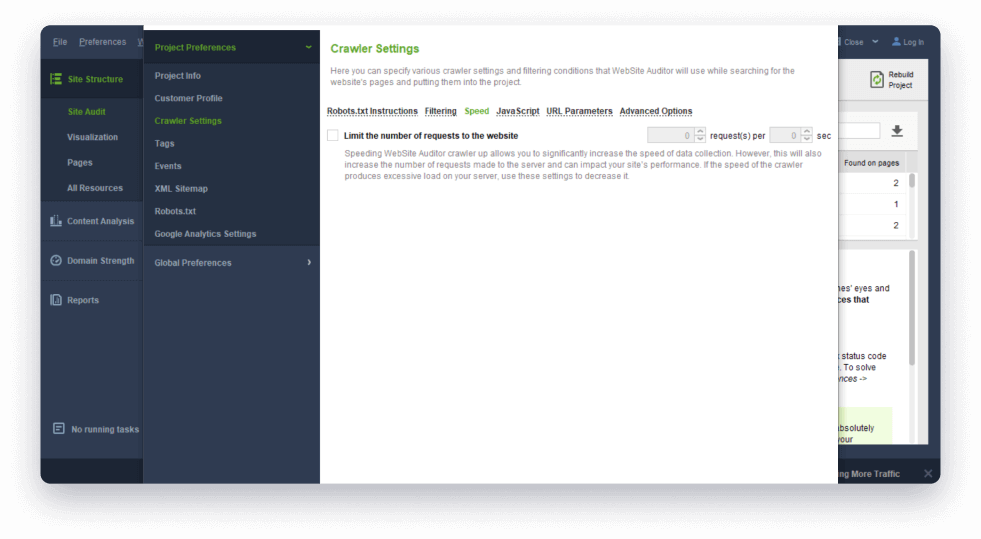

Crawlen Sie jede Website in wenigen Minuten.

Der SEO Spider von WebSite Auditor sorgt für eine leistungsstarke, gründliche und schnelle Analyse. Selbst wenn Sie große Websites für E-Commerce crawlen, dauert die Prüfung jetzt nur noch wenige Minuten; Und natürlich gibt es eine separate Einstellung, mit der Sie die Crawling-Geschwindigkeit nach Ihren Wünschen erhöhen (oder verringern) können.

Wo Sie es finden: Unter „Einstellungen“ > „Crawler-Einstellungen“ auf der Registerkarte „Geschwindigkeit“.

4

Überwachen Sie Weiterleitungen und Canonicals.

Sie können die Ziel-URLs jeder Weiterleitung zusammen mit kanonischen URLs und Meta-Refresh-URLs in Ihrem WebSite Auditor-Arbeitsbereich sehen. So können Sie schnell sicherstellen, dass jede Weiterleitung und kanonische Weiterleitung korrekt eingerichtet ist und auf die richtige Seite verweist, und Einstiegsseiten finden und reparieren durch Entfernen der Metaaktualisierung.

Wo Sie es finden: Klicken Sie unter „Site-Struktur“ > „Seiten“ mit der rechten Maustaste auf die Kopfzeile einer beliebigen Spalte und fügen Sie Ihrem Arbeitsbereich die Spalten „Umleitungs-URL“, „Kanonische URL“ und „Meta-Aktualisierungs-URL “ hinzu.

5

Suchen Sie nach verwaisten Seiten.

Diese Option durchsucht den Google-Index und die Sitemap nach Seiten, die nicht von anderen Seiten Ihrer Website aus verlinkt sind, aber dennoch vorhanden sind. Dabei kann es sich um alte Seiten handeln, die Sie vergessen haben, zu verlinken, um Seiten, die bei einer Site-Migration oder Neugestaltung übersehen wurden, oder sogar um ein Zeichen dafür, dass Ihre Site gehackt wurde. Sie finden diese Seiten in Ihrem Projekt unter dem Tag „Orphan Pages“. Wenn es sich um wichtige Seiten handelt, auf die nicht versehentlich verlinkt wird, beginnen Sie damit, intern darauf zu verlinken, um Suchmaschinen dazu zu bewegen, sie häufiger zu crawlen.

Wo Sie es finden: Aktivieren Sie in Schritt 1 das Kontrollkästchen „Expertenoptionen anzeigen“ und wählen Sie „Nach verwaisten Seiten suchen“ aus. Gehen Sie dazu für ein bestehendes Projekt zu „Einstellungen“ > „Crawler-Einstellungen“ und klicken Sie auf „Projekt neu erstellen“.

6

Achten Sie auf Ihre Antwortheader.

Der WebSite Auditor SEO Spider analysiert nicht nur den HTML-Code Ihrer Seiten, sondern auch deren HTTP-Antwortheader, was besonders für professionelle SEO-Berater nützlich sein kann. Hier ein paar Beispiele:

- Das Feld „Server“ kann wichtig sein, wenn Sie serverseitige Weiterleitungen implementieren möchten – verschiedene Servertypen erfordern unterschiedliche Arten der Umleitung. Beispielsweise erfordert ein Apache-Server möglicherweise.htaccess-Änderungen, während ein IIS-Server bedeutet, dass Sie das URL-Rewrite-Modul verwenden müssen.

- „Link“ ist das Header-Feld, das verwendet wird, um eine bestimmte Art von Beziehung zwischen der angeforderten Ressource und anderen Ressourcen anzugeben. Wie das HTML-Tag <link> kann dieses Header-Feld zur Angabe von Canonicals, Hreflang, Shortlinks und vielen anderen Linktypen verwendet werden, die für SEO wichtig sind.

- Das Header-Feld „X-Robots-Tag“ enthält Roboteranweisungen, einschließlich der „noindex“-Regel. Wenn Sie eine Seite gefunden haben, die nicht indiziert ist, und nicht herausfinden können, warum, kann dieses Feld die Antwort sein.

Wo Sie es finden: Klicken Sie unter „Site-Struktur“ > „Alle Ressourcen“ auf eine beliebige Ressource und wechseln Sie im unteren Teil des Bildschirms zur Kopfzeile „Antwort“.

Planen Sie Aufgaben, speichern Sie Crawls und berichten Sie an Kunden.

Mit seinen umfangreichen benutzerdefinierten Extraktionsmöglichkeiten ist der Website Auditor SEO Spider ein großartiges SEO-Prüfungstool für Profis. Planen Sie Ihre SEO-Audits, speichern Sie Crawls als Tabellenkalkulationen oder CSV-Dateien und melden Sie Probleme mit nur wenigen Klicks an Kunden.

Hören Sie auf, Website-Probleme zu übersehen, die Ihrem Ranking schaden.

Ein gründlicher Site-Crawl ist die technische Grundlage für den SEO-Erfolg. Egal, ob Sie ein

Kleinunternehmer sind und nur einmal im Monat Website-Audits durchführen, oder ein technischer SEO-Experte,

der Dutzende großer Websites für Kunden prüft, das Website Auditor SEO Spider-Tool ist ein unbestrittenes

Muss.

Diese SEO-Software funktioniert auf jedem Betriebssystem, sei es Windows, MacOS oder Ubuntu,

optimiert Websites in jeder Sprache und für die Suchmaschinen jedes Landes und ist in verschiedenen

Schnittstellensprachen verfügbar.

Laden Sie die WebSite Auditor-Tools kostenlos über den untenstehenden Link herunter, um bis

zu 500 Ressourcen einer Website zu crawlen, oder erwerben Sie eine WebSite Auditor-Lizenz für unbegrenztes

Crawling.

Viel Spaß beim Auditieren!