146105

•

11-minütige Lektüre

•

Wie findet man alle auf einer Website vorhandenen Seiten? Die erste Idee, die mir in den Sinn kommt, ist, den Domainnamen der Website zu googeln.

Aber was ist mit URLs, die nicht indiziert werden können? Oder verwaiste Seiten? Oder Webcache?

Es ist ziemlich einfach, alle Seiten einer Website zu finden. Es erfordert jedoch etwas besondere Aufmerksamkeit, wenn man bedenkt, dass es Seiten gibt, die den Augen von Besuchern oder Suchbots verborgen bleiben. Dieser Leitfaden zeigt 8 verschiedene Methoden zum Auffinden aller Seiten der Website sowie die zu verwendenden Tools.

So finden Sie alle Seiten einer Website:

Es gibt unzählige Gründe, warum Sie möglicherweise alle Seiten einer Website finden müssen. Um ein paar zu nennen:

1. Um die Website eines neuen Kunden zu prüfen und Indexierungsprobleme zu finden.

Technische Probleme wie defekte Links, Serverfehler, langsame Seitengeschwindigkeit oder schlechte mobile Benutzerfreundlichkeit verhindern, dass Google die Seiten indexiert. Site-Audits zeigen also, wie viele URLs eine Site hat und welche davon problematisch sind. Letztendlich hilft es SEOs, den Umfang der zukünftigen Arbeit im Projekt einzuschätzen.

2. Um Seiten Ihrer eigenen Website zu erkennen, die versehentlich nicht indiziert wurden.

Wenn Ihre Website doppelten Inhalt enthält, kann es sein, dass Google nicht alle Duplikate indiziert. Das Gleiche gilt für lange Redirect-Ketten und 404-URLs: Wenn es viele davon auf einer Seite gibt, wird das Crawling-Budget umsonst ausgegeben. Dies hat zur Folge, dass die Suchbots die Seite seltener besuchen und sie insgesamt schlechter indiziert wird. Deshalb sind regelmäßige Audits erforderlich, auch wenn im Allgemeinen etwas normal aussieht.

3. Um indizierte Seiten zu erkennen, die nicht für die Google-Indexierung gedacht sind.

Einige Seiten werden im Suchindex nicht benötigt – zum Beispiel Anmeldeseiten für Administratoren, Seiten in der Entwicklung oder Einkaufswagen. Dennoch kann es sein, dass diese Seiten aufgrund widersprüchlicher Regeln oder Fehler in Ihren technischen Dateien gegen Ihren Willen indiziert werden. Wenn Sie sich beispielsweise ausschließlich auf robots.txt verlassen, um eine Seite nicht zuzulassen, wird die URL möglicherweise trotzdem gecrawlt und in der Suche angezeigt.

4. Um veraltete Seiten zu finden und eine vollständige Überarbeitung des Inhalts zu planen.

Google ist bestrebt, seinen Nutzern die bestmöglichen Ergebnisse zu bieten. Wenn Ihre Inhalte also von schlechter Qualität, dünn oder doppelt vorhanden sind, kann es sein, dass sie nicht indiziert werden. Es ist gut, eine Liste aller Ihrer Seiten zu haben, um zu wissen, welche Themen Sie noch nicht behandelt haben. Wenn Sie Ihr gesamtes Content-Inventar zur Hand haben, können Sie Ihre Content-Strategie effektiver planen.

5. Um verwaiste Seiten zu finden und Verlinkungsstrategien zu planen.

Waisen sind Seiten ohne eingehende Links, weshalb Benutzer und Suchbots sie selten oder gar nicht besuchen. Verwaiste Seiten werden möglicherweise in Google indiziert und ziehen zufällige Benutzer an. Eine große Anzahl verwaister Seiten auf einer Website beeinträchtigt jedoch ihre Autorität: Die Struktur der Website ist nicht glasklar, die Seiten sehen möglicherweise nicht hilfreich oder unwichtig aus, und all das Totholz beeinträchtigt die Gesamtsichtbarkeit der Website.

6. Um eine Website neu zu gestalten und ihre Architektur zu ändern.

Um die Neugestaltung einer Website zu planen und das Benutzererlebnis zu verbessern, müssen Sie zunächst alle Seiten und relevanten Kennzahlen finden.

Eine klare und organisierte Struktur mit einer logischen Hierarchie aller Seiten kann Suchmaschinen dabei helfen, Ihre Inhalte leichter zu finden. Daher müssen alle wichtigen URLs innerhalb eines, zwei oder drei Klicks von der Startseite aus erreichbar sein.

Obwohl die Benutzererfahrung keinen Einfluss auf Crawling und Ranking hat, ist sie für die Qualitätssignale Ihrer Website von Bedeutung – erfolgreiche Käufe, die Anzahl der wiederkehrenden Besucher, Seitenaufrufe pro Besucher und viele weitere Kennzahlen zeigen, wie nützlich Ihre Website für die Besucher ist.

7. Um die Websites von Wettbewerbern zu analysieren.

Indem Sie die Seiten Ihrer Konkurrenten prüfen, können Sie tiefer in deren SEO-Strategien eintauchen: Zeigen Sie deren Top-Traffic-Seiten, die am häufigsten verlinkten Seiten, die besten Empfehlungsquellen usw. auf. Auf diese Weise können Sie wertvolle Erkenntnisse gewinnen und lernen, wie sie für Ihre Konkurrenten gut funktionieren. Sie können ihre Techniken ausleihen und die Ergebnisse vergleichen, um zu sehen, wie Sie Ihre eigene Website verbessern können.

Es gibt viele Möglichkeiten, alle Seiten einer Website zu finden, Sie können jedoch für jeden Fall eine andere Methode verwenden. Sehen wir uns also die Vor- und Nachteile jeder Methode an und wie man sie ohne großen Aufwand anwenden kann.

Die Google-Suche kann schnell dabei helfen, alle Seiten einer Website zu finden. Geben Sie einfach „Website: Ihre Domain“ in die Suchleiste ein und Google zeigt Ihnen alle Seiten der Website an, die es indiziert hat.

Beachten Sie jedoch, dass die vom Operator „site:“ angezeigten Suchergebnisse nicht unbedingt die genaue Anzahl der indizierten Seiten Ihrer Website widerspiegeln.

Erstens gibt es keine Garantie dafür, dass Google jede Seite direkt nach dem Crawlen indiziert. Es kann aus verschiedenen Gründen bestimmte Seiten aus dem Index ausschließen: Beispielsweise betrachtet es einige Seiten als Duplikate oder von geringer Qualität.

Zweitens zeigt der Suchoperator „site:“ möglicherweise auch Seiten an, die von Ihrer Website entfernt wurden, diese werden jedoch als zwischengespeicherte oder archivierte Seiten bei Google gespeichert.

Daher ist die Suchanfrage „site:“ ein guter Anfang, um sich ein ungefähres Bild davon zu machen, wie groß Ihre Website ist. Um jedoch die restlichen Seiten zu finden, die möglicherweise im Index fehlen, benötigen Sie einige andere Tools.

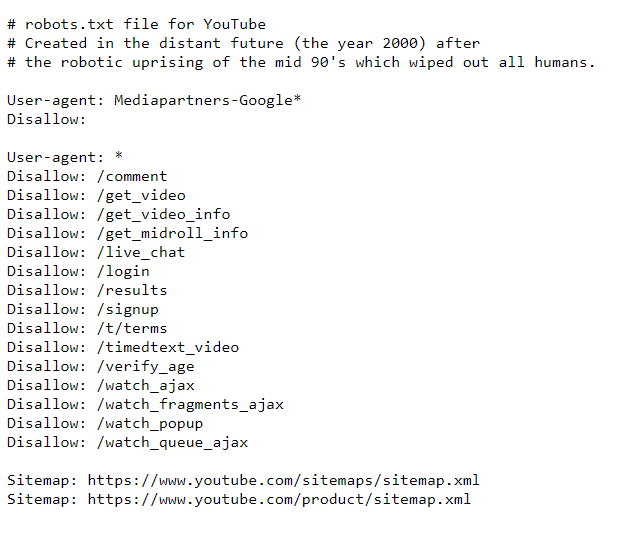

Robots.txt ist eine technische Datei, die Such-Bots anweist, wie sie Ihre Website mithilfe der Zulassungs-/Nichtzulassungsregeln für einzelne Seiten oder ganze Verzeichnisse crawlen sollen.

Daher zeigt Ihnen die Datei nicht alle Seiten Ihrer Website an. Es kann Ihnen jedoch dabei helfen, Seiten zu finden, auf die Such-Bots keinen Zugriff haben.

Wie man

Hier sind die Schritte, wie Sie die eingeschränkten Seiten mithilfe von robots.txt finden:

Hier ist ein Beispiel für Roboteranweisungen für YouTube.

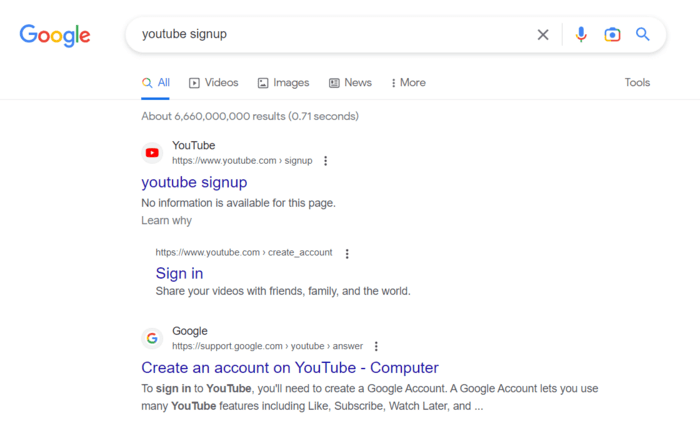

Überprüfen Sie, wie es funktioniert. Beispielsweise ist die Anmeldeseite nicht zulässig. Sie können es jedoch weiterhin bei einer Google-Suche finden – beachten Sie, dass für die Seite keine beschreibenden Informationen verfügbar sind.

Es ist notwendig, Ihre robots.txt-Regeln erneut zu überprüfen, um sicherzustellen, dass alle Ihre Seiten ordnungsgemäß gecrawlt werden. Daher benötigen Sie möglicherweise ein Tool wie die Google Search Console oder einen Site-Crawler, um es zu überprüfen. Ich werde gleich darauf eingehen.

Und wenn Sie bisher mehr über den Zweck der Datei erfahren möchten, lesen Sie diese Anleitung zum Ausblenden von Webseiten vor der Indizierung.

Eine Sitemap ist eine weitere technische Datei, die Webmaster für die ordnungsgemäße Indexierung der Website verwenden. Dieses Dokument, oft im XML-Format, listet alle URLs einer Website auf, die indexiert werden sollen. Eine Sitemap ist eine wertvolle Informationsquelle über die Struktur und den Inhalt einer Website.

Große Websites können mehrere Sitemaps haben: Da die Dateigröße auf 50.000 URLs und 50 MB begrenzt ist, kann sie in mehrere aufgeteilt werden und eine separate Sitemap für Verzeichnisse, Bilder, Videos usw. enthalten. E-Commerce-Plattformen wie Shopify oder Wix Sitemaps automatisch generieren. Für andere gibt es Plugins oder Sitemap-Generator-Tools zum Erstellen der Dateien.

Wie man

Mit der Sitemap einer Website können Sie unter anderem alle Seiten darauf leicht finden und sicherstellen, dass sie indiziert sind:

Sie sollten auch von Zeit zu Zeit die Richtigkeit Ihrer Sitemap überprüfen, da es auch hier zu Problemen kommen kann: Sie ist möglicherweise leer, antwortet mit einem 404-Code, ist vor langer Zeit im Cache gespeichert oder sie enthält einfach die falschen URLs, die Sie nicht möchten im Index erscheinen soll.

Eine gute Methode zur Validierung Ihrer Sitemap ist die Verwendung eines Website-Crawling-Tools. Es gibt mehrere Website-Crawler-Tools, die online verfügbar sind, und eines davon ist WebSite Auditor, ein leistungsstarkes SEO-Tool für Site-weite Audits. Sehen wir uns an, wie es Ihnen dabei helfen kann, alle Seiten einer Website zu finden und technische Dateien zu validieren.

Wie man

So können Sie mit WebSite Auditor alle Seiten Ihrer Website finden:

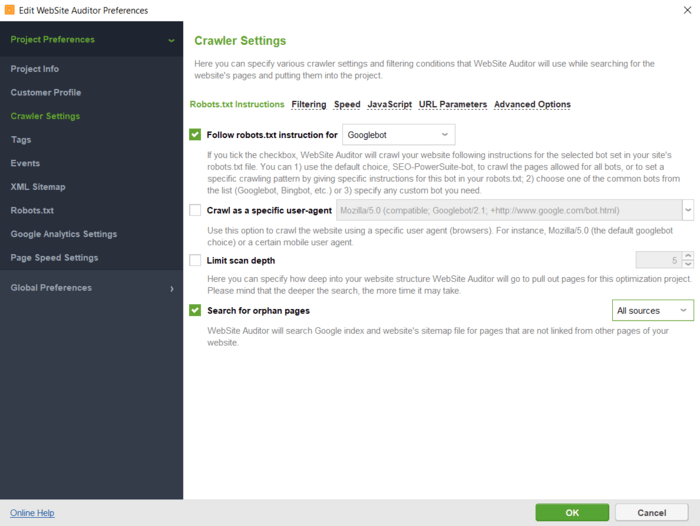

Sie können die Anweisungen für einen bestimmten Suchbot oder Benutzeragenten angeben; Weisen Sie den Crawler an, URL-Parameter zu ignorieren, eine passwortgeschützte Website zu crawlen, eine Domain allein oder zusammen mit Subdomains zu crawlen usw.

Nachdem Sie auf „OK“ geklickt haben, prüft das Tool Ihre Website und sammelt alle Seiten im Abschnitt „Site-Struktur > Seiten“.

WebSite Auditor hilft Ihnen dabei, noch einmal zu überprüfen, ob die URLs ordnungsgemäß für Suchmaschinen optimiert sind. Sie werden sich in wenigen Minuten mit dem Tool vertraut machen, da die Einrichtung schnell erfolgt und die Benutzeroberfläche recht intuitiv ist.

Hier ist eine kurze Videoanleitung für Sie:

Sehen wir uns an, was Sie mit dem Website-Crawling-Tool erreichen können.

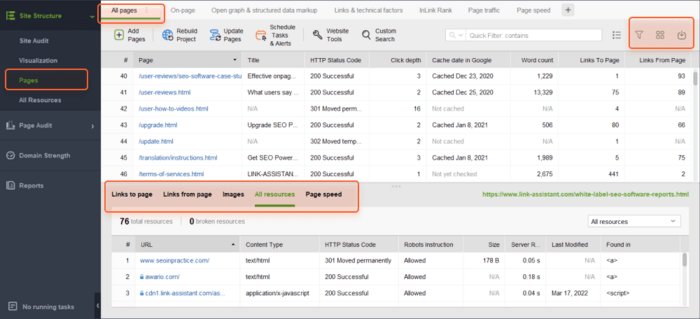

Auf der Registerkarte „Alle Seiten“ können Sie die Liste nach URL, Titel oder einer anderen Spalte sortieren, indem Sie auf die Spaltenüberschrift klicken.

Sie können das Suchfeld verwenden, um die Seitenliste nach Schlüsselwort oder Seiten-URL zu filtern. Dies kann hilfreich sein, wenn Sie nach einer bestimmten Seite oder Seitengruppe suchen.

Darüber hinaus können Sie sichtbare Spalten hinzufügen, um weitere Informationen zu dieser Seite anzuzeigen, z. B. Meta-Tags, Überschriften, Schlüsselwörter, Weiterleitungen oder andere SEO-Elemente auf der Seite.

Abschließend können Sie auf eine beliebige URL klicken, um alle Ressourcen auf der Seite in der unteren Hälfte des Arbeitsbereichs zu untersuchen.

Alle Daten können im Tool verarbeitet oder im CSV- oder Excel-Format kopiert/exportiert werden.

Der Abschnitt „Site-Audit“ zeigt Ihnen Seitenlisten, aufgeteilt nach Fehlertypen, wie zum Beispiel:

Unter jeder Art von Problem finden Sie eine Erklärung, warum dieser Faktor wichtig ist, sowie einige Vorschläge zur Behebung.

Außerdem können Sie Ihre visuelle Sitemap unter Site-Struktur > Visualisierung untersuchen, die die Beziehungen zwischen all Ihren URLs anzeigt. Mit der interaktiven Karte können Sie Seiten und Links hinzufügen oder entfernen, um die Struktur Ihrer Website anzupassen. Sie können den internen PageRank-Wert neu berechnen und die Seitenaufrufe überprüfen (wie von Google Analytics verfolgt).

Laden Sie WebSite Auditor herunterDarüber hinaus prüft WebSite Auditor auch die Verfügbarkeit Ihrer robots.txt-Datei und der Sitemap.

Damit können Sie die technischen Dateien in den Website-Tools bearbeiten und sie mit den richtigen Einstellungen direkt auf Ihre Website hochladen.

Beim Bearbeiten der Dateien müssen Sie keine besondere Syntax beachten – wählen Sie einfach die erforderlichen URLs aus und wenden Sie die erforderlichen Regeln an. Klicken Sie dann, um die Dateien zu generieren und auf Ihrem Computer zu speichern oder per FTP auf die Website hochzuladen.

Laden Sie WebSite Auditor herunterEin weiteres großartiges Tool zum Entdecken aller Seiten Ihrer Website ist die Google Search Console. Es hilft Ihnen, die Indexierung der Seiten zu überprüfen und die Probleme aufzudecken, die Such-Bots daran hindern, diese URLs korrekt zu indexieren.

Wie man

Sie können eine Aufschlüsselung aller Ihrer Seiten nach ihrem Indexierungsstatus erhalten, einschließlich der Seiten, die noch nicht indiziert wurden.

So finden Sie alle Seiten Ihrer Website mit der Search Console:

1. Gehen Sie zum Indexierungsbericht und klicken Sie auf Daten zu indizierten Seiten anzeigen. Sie sehen alle Seiten, die der Suchbot zuletzt auf Ihrer Website gecrawlt hat. Beachten Sie jedoch, dass die Tabelle maximal 1.000 URLs enthalten kann. Es gibt einen Schnellfilter, um alle bekannten Seiten nach allen übermittelten URLs usw. zu sortieren.

2. Aktivieren Sie die Registerkarte Nicht indiziert. Im Folgenden erfahren Sie vom Tool, warum die einzelnen URLs nicht indexiert sind.

Klicken Sie auf jeden Grund und sehen Sie sich die von dem Problem betroffenen URLs an.

Die Schwierigkeit besteht darin, dass Sie nicht nur die Haupt-URLs Ihrer Seiten erhalten, sondern auch Ankerlinks, Paginierungsseiten, URL-Parameter und anderen Müll, der eine manuelle Sortierung erfordert. Aufgrund der Beschränkung auf 1.000 Einträge in der Tabelle ist die Liste möglicherweise unvollständig.

Beachten Sie unter anderem, dass verschiedene Suchmaschinen möglicherweise andere Indexierungsregeln haben und Sie deren Webmaster-Tools verwenden müssen, um solche Probleme zu finden und zu beheben. Verwenden Sie beispielsweise die Tools Bing Webmaster, Yandex Webmaster, Naver Webmaster und andere, um die Indizierung in den jeweiligen Suchmaschinen zu überprüfen.

Ich denke, Google Analytics ist eine der am weitesten verbreiteten Analyseplattformen, daher ist jeder Websitebesitzer oder -redakteur damit vertraut. Das gute alte Universal Analytics wird bald durch Google Analytics 4 ersetzt. Sehen wir uns also beide Versionen des Tools an.

Wie man

Gehen Sie folgendermaßen vor, um die Seiten Ihrer Website in Universal Analytics von Google zu erfassen:

Sie sehen die Seiten mit ihren Benutzerverhaltensstatistiken, wie z. B. Seitenaufrufe, Absprungrate, durchschnittliche Verweildauer auf der Seite usw. Achten Sie auf Seiten mit der geringsten Anzahl an Seitenaufrufen im gesamten Zeitraum – wahrscheinlich handelt es sich um verwaiste Seiten.

So erstellen Sie einen ähnlichen Ablauf in Google Analytics 4:

Genau wie bei der Konsole enthält sie URL-Parameter und dergleichen. Sie können die Seitenliste als CSV- oder Excel-Tabelle exportieren, indem Sie oben auf der Seite auf die Schaltfläche „Exportieren“ klicken.

Manche Websites sind wirklich riesig und selbst leistungsstarke SEO-Spider haben möglicherweise Schwierigkeiten, alle ihre Seiten zu crawlen. Die Protokollanalyse ist eine gute Option, um alle Seiten großer Websites zu finden und zu untersuchen.

Durch die Analyse der Protokolldatei Ihrer Website können Sie alle Seiten identifizieren, die Besucher aus dem Web erhalten, ihre HTTP-Antworten, wie oft Crawler die Seiten besuchen usw.

Protokolldateien liegen auf Ihrem Server und Sie benötigen die erforderliche Zugriffsebene, um sie abzurufen, sowie ein Protokollanalysetool. Daher eignet sich diese Methode eher für technisch versierte Personen, Webmaster oder Entwickler.

Wie man

Hier sind die Schritte, um alle Seiten Ihrer Website mithilfe der Protokollanalyse zu finden:

Eine andere Möglichkeit, alle Seiten einer Website zu finden, besteht darin, sich an Ihr Content-Management-System (CMS) zu wenden, da es alle URLs der Website enthält, die Sie einmal erstellt haben. Ein Beispiel für CMS sind Wordpress oder Squarespace, die Tools zum Erstellen von Websites für die Bearbeitung von Inhalten in verschiedenen Bereichen enthalten – Nachrichten und Blogging, E-Commerce, Unternehmensseiten und dergleichen.

Wie man

Obwohl sich CMS optisch stark unterscheiden, gelten für die meisten von ihnen die allgemeinen Schritte:

Beachten Sie, dass es Kategorien, Blog-Beiträge oder Zielseiten geben kann, bei denen es sich um verschiedene Seitentypen handelt, die zu unterschiedlichen Abschnitten im CMS gehören können.

Die meisten CMS ermöglichen das Sortieren der URLs nach Erstellungsdatum, Autor, Kategorie oder anderen Kriterien. Sie können das Suchfeld auch verwenden, um die Seitenliste nach Schlüsselwörtern oder Titeln zu filtern.

Um alle Seiten einer Website zu finden, gibt es eine Vielzahl von Methoden und Tools. Für welche Sie sich entscheiden, hängt vom Zweck und dem Umfang der auszuführenden Arbeiten ab.

Ich hoffe, dass Sie diese Liste hilfreich fanden und nun problemlos alle Seiten Ihrer Website sammeln können, auch wenn Sie neu in der Suchmaschinenoptimierung sind.

Wenn Sie eine Frage haben, die noch nicht beantwortet wurde, können Sie diese gerne in unserer Benutzergruppe auf Facebook stellen.