101081

•

20 minuten gelezen

•

Het PageRank-algoritme (of kortweg PR) is een systeem voor het rangschikken van webpagina's, ontwikkeld door Larry Page en Sergey Brin aan de Stanford University eind jaren negentig. PageRank was eigenlijk de basis waarop Page en Brin de Google-zoekmachine creëerden.

Sindsdien zijn er vele jaren verstreken en uiteraard zijn de ranking-algoritmen van Google veel ingewikkelder geworden. Zijn ze nog steeds gebaseerd op PageRank? Hoe beïnvloedt PageRank de ranking precies, zou dit een van de redenen kunnen zijn waarom uw ranking is gedaald, en waar moeten SEO’s zich in de toekomst op voorbereiden? Nu gaan we alle feiten en mysteries rond PageRank vinden en samenvatten om het plaatje duidelijk te maken. Nou ja, zoveel als we kunnen.

Zoals hierboven vermeld, probeerden Brin en Page in hun universitaire onderzoeksproject een systeem uit te vinden om de autoriteit van webpagina's in te schatten. Ze besloten dat systeem te bouwen op basis van links, die dienden als vertrouwensstemmen voor een pagina. Volgens de logica van dat mechanisme geldt: hoe meer externe bronnen naar een pagina linken, hoe waardevoller de informatie voor gebruikers is. En PageRank (een score van 0 tot 10 berekend op basis van de kwantiteit en kwaliteit van inkomende links) toonde de relatieve autoriteit van een pagina op internet.

Laten we eens kijken hoe PageRank werkt. Elke link van de ene pagina (A) naar de andere (B) levert een zogenaamde stem op, waarvan het gewicht afhangt van het gezamenlijke gewicht van alle pagina's die naar pagina A linken. En we kunnen hun gewicht pas weten als we berekenen het, dus het proces verloopt in cycli.

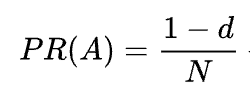

De wiskundige formule van de originele PageRank is als volgt:

Waar A, B, C en D enkele pagina's zijn, is L het aantal links dat vanaf elk van deze pagina's wordt verzonden, en N het totale aantal pagina's in de verzameling (dwz op internet).

Wat d betreft, is d de zogenaamde dempingsfactor. Aangezien PageRank wordt berekend door het gedrag te simuleren van een gebruiker die willekeurig op een pagina terechtkomt en op links klikt, passen we deze dempende d- factor toe als de kans dat de gebruiker zich verveelt en een pagina verlaat.

Zoals je uit de formule kunt zien, zal de PR niet nul zijn als er geen pagina's zijn die naar de pagina verwijzen

Omdat de kans groot is dat de gebruiker deze pagina niet via andere pagina's kan bereiken, maar bijvoorbeeld via bladwijzers.

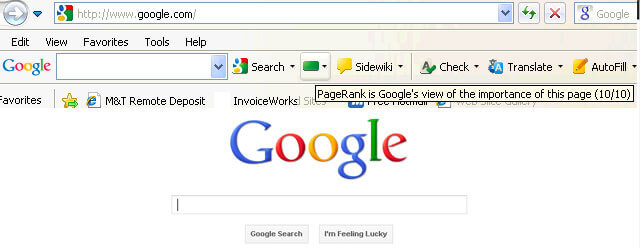

In eerste instantie was de PageRank-score publiekelijk zichtbaar in de Google Toolbar, en elke pagina had een score van 0 tot 10, hoogstwaarschijnlijk op een logaritmische schaal.

De ranking-algoritmen van Google uit die tijd waren heel eenvoudig: hoge PR en trefwoorddichtheid waren de enige twee dingen die een pagina nodig had om hoog te scoren op een SERP. Als gevolg hiervan werden webpagina's volgepropt met trefwoorden en begonnen website-eigenaren de PageRank te manipuleren door kunstmatig spammy-backlinks te laten groeien. Dat was gemakkelijk te doen: linkboerderijen en linkverkoop waren er om website-eigenaren een ‘helpende hand’ te geven.

Google heeft besloten om linkspam terug te bestrijden. In 2003 strafte Google de website van het advertentienetwerkbedrijf SearchKing wegens linkmanipulatie. SearchKing klaagde Google aan, maar Google won. Het was een manier waarop Google probeerde iedereen te weerhouden van linkmanipulatie, maar het leidde tot niets. Linkboerderijen gingen gewoon ondergronds en hun aantal vermenigvuldigde zich enorm.

Bovendien nam het aantal spamachtige reacties op blogs ook toe. Bots vielen de reacties van bijvoorbeeld WordPress-blogs aan en lieten enorme aantallen ‘klik-hier-om-magische-pillen-kopen’- reacties achter. Om spam en PR-manipulatie in reacties te voorkomen, introduceerde Google in 2005 de nofollow- tag. En opnieuw werd wat Google bedoelde om een succesvolle stap in de linkmanipulatie-oorlog te worden, op een verwrongen manier geïmplementeerd. Mensen begonnen nofollow- tags te gebruiken om PageRank kunstmatig naar de pagina's te leiden die ze nodig hadden. Deze tactiek werd bekend als PageRank-sculpting.

Om PR-sculpting te voorkomen, heeft Google de manier veranderd waarop PageRank stroomt. Als een pagina voorheen zowel nofollow- als dofollow- links had, werd al het PR-volume van de pagina doorgegeven aan andere pagina's waaraan de dofollow- links waren gekoppeld. In 2009 begon Google de PR van een pagina gelijk te verdelen over alle links die de pagina had, maar alleen de aandelen door te geven die aan de dofollow- links waren gegeven.

Google was klaar met het bewerken van PageRank en stopte de oorlog met linksspam niet en begon vervolgens de PageRank-score uit de ogen van het publiek te halen. Eerst lanceerde Google de nieuwe Chrome-browser zonder Google Toolbar waarin de PR-score werd getoond. Vervolgens stopten ze met het rapporteren van de PR-score in Google Search Console. Toen stopte de Firefox-browser met het ondersteunen van Google Toolbar. In 2013 werd PageRank voor de laatste keer bijgewerkt voor Internet Explorer en in 2016 sloot Google de Toolbar officieel af voor het publiek.

Nog een manier waarop Google linkschema's bestreed was de Penguin-update, waarmee websites met dubieuze backlinkprofielen van de ranglijst werden ontdaan. Penguin, dat in 2012 werd uitgerold, werd geen onderdeel van het realtime algoritme van Google, maar was eerder een 'filter' dat zo nu en dan werd bijgewerkt en opnieuw werd toegepast op de zoekresultaten. Als een website door Penguin werd bestraft, moesten SEO's hun linkprofielen zorgvuldig beoordelen en giftige links verwijderen, of ze toevoegen aan een disavow-lijst (een functie die destijds werd geïntroduceerd om Google te vertellen welke inkomende links ze moesten negeren bij het berekenen van de PageRank). Nadat ze de linkprofielen op die manier hadden gecontroleerd, moesten SEO's ongeveer een half jaar wachten totdat het Penguin-algoritme de gegevens opnieuw had berekend.

In 2016 maakte Google Penguin onderdeel van zijn kernrangschikkingsalgoritme. Sindsdien werkt het in realtime, waardoor het algoritmisch veel succesvoller omgaat met spam.

Tegelijkertijd werkte Google aan het faciliteren van kwaliteit in plaats van kwantiteit van links, en legde dit vast in zijn kwaliteitsrichtlijnen tegen linkschema's.

Nou, we zijn klaar met het verleden van PageRank. Wat gebeurt er nu?

In 2019 zei een voormalige Google-medewerker dat het oorspronkelijke PageRank-algoritme sinds 2006 niet meer in gebruik was en werd vervangen door een ander, minder hulpbronnenintensief algoritme naarmate het internet groter werd. Dat zou wel eens waar kunnen zijn, aangezien Google in 2006 het nieuwe patent Producing a ranking for Pages Using Distances in a Web-Link Graph heeft ingediend.

Ja dat is zo. Het is niet dezelfde PageRank als begin jaren 2000, maar Google blijft sterk afhankelijk van de linkautoriteit. Een voormalige Google-medewerker Andrey Lipattsev vertelde dit bijvoorbeeld in 2016. In een Google Q&A-hangout vroeg een gebruiker hem wat de belangrijkste rankingsignalen waren die Google gebruikte. Andrey's antwoord was vrij eenvoudig.

Ik kan je vertellen welke dat zijn. Het zijn inhoud en links die naar uw site verwijzen.

In 2020 bevestigde John Mueller dat nogmaals:

Ja, we gebruiken PageRank intern, naast vele, vele andere signalen. Het is niet helemaal hetzelfde als het originele artikel, er zijn veel eigenaardigheden (bijvoorbeeld afgewezen links, genegeerde links, enz.), en nogmaals, we gebruiken veel andere signalen die veel sterker kunnen zijn.

Zoals u kunt zien, leeft PageRank nog steeds en wordt het actief gebruikt door Google bij het rangschikken van pagina's op internet.

Wat interessant is, is dat Google-medewerkers ons eraan blijven herinneren dat er nog heel veel andere Google-rangschikkingsfactoren zijn. Maar wij bekijken dit met een korreltje zout. Als je bedenkt hoeveel moeite Google heeft gestoken in het bestrijden van linkspam, zou het in het belang van Google kunnen zijn om de aandacht van SEO's af te leiden van de manipulatiegevoelige factoren (zoals backlinks zijn) en deze aandacht te verleggen naar iets onschuldigs en aardigs. Maar omdat SEO's goed tussen de regels door kunnen lezen, blijven ze PageRank als een sterk rankingsignaal beschouwen en kunnen ze backlinks op alle mogelijke manieren laten groeien. Ze gebruiken nog steeds PBN's, beoefenen wat grijze-hoed -gelaagde linkbuilding, kopen links, enzovoort, net zoals het lang geleden was. Terwijl PageRank leeft, zal linkspam ook blijven bestaan. We raden dat allemaal niet aan, maar dat is wat de SEO-realiteit is, en dat moeten we begrijpen.

Nou, je hebt het idee dat PageRank nu niet meer de PageRank is van 20 jaar geleden.

Een van de belangrijkste moderniseringen van PR was de overstap van het hierboven kort genoemde Random Surfer-model naar het Reasonable Surfer-model in 2012. Reasonable Surfer gaat ervan uit dat gebruikers zich niet chaotisch gedragen op een pagina en alleen op de links klikken waarin ze geïnteresseerd zijn op de pagina moment. Als u bijvoorbeeld een blogartikel leest, is de kans groter dat u op een link in de inhoud van het artikel klikt dan op een link naar de Gebruiksvoorwaarden in de voettekst.

Bovendien kan Reasonable Surfer potentieel een grote verscheidenheid aan andere factoren gebruiken bij het evalueren van de aantrekkelijkheid van een link. Al deze factoren zijn zorgvuldig besproken door Bill Slawski in zijn artikel, maar ik wil me graag concentreren op de twee factoren, die SEO's vaker bespreken. Dit zijn linkpositie en paginaverkeer. Wat kunnen we over deze factoren zeggen?

Een link kan zich overal op de pagina bevinden: in de inhoud, het navigatiemenu, de biografie van de auteur, de voettekst en feitelijk elk structureel element dat de pagina bevat. En verschillende linklocaties beïnvloeden de linkwaarde. John Mueller bevestigde dat en zei dat links in de hoofdinhoud meer wegen dan alle andere:

Dit is het gedeelte van de pagina waar je je primaire inhoud hebt, de inhoud waar deze pagina eigenlijk over gaat, niet het menu, de zijbalk, de voettekst, de koptekst… Dan is dat iets waar we rekening mee houden en we proberen om deze links te gebruiken.

Er wordt dus gezegd dat voettekstlinks en navigatielinks minder gewicht in de schaal leggen. En dit feit wordt van tijd tot tijd niet alleen bevestigd door Google-woordvoerders, maar ook door praktijkgevallen.

In een recent geval gepresenteerd door Martin Hayman op BrightonSEO, voegde Martin de link die hij al in zijn navigatiemenu had toe aan de hoofdinhoud van de pagina's. Als gevolg hiervan ondervonden deze categoriepagina's en de pagina's waarnaar zij linkten een verkeerstoename van 25%.

Dit experiment bewijst dat inhoudslinks zwaarder wegen dan alle andere links.

Wat de links in de biografie van de auteur betreft, gaan SEO's ervan uit dat biolinks iets wegen, maar minder waardevol zijn dan bijvoorbeeld inhoudslinks. Hoewel we hier niet veel bewijs hebben, behalve wat Matt Cutts zei toen Google actief vocht tegen buitensporig gastbloggen voor backlinks.

John Mueller verduidelijkte de manier waarop Google omgaat met verkeer en gebruikersgedrag in termen van het doorgeven van link juice in een van de Search Console Central-hangouts. Een gebruiker vroeg Mueller of Google rekening houdt met de klikkans en het aantal linkklikken bij het evalueren van de kwaliteit van een link. De belangrijkste conclusies uit het antwoord van Mueller waren:

Google houdt bij het beoordelen van de kwaliteit van de link geen rekening met klikken op links en de klikkans.

Google begrijpt dat er vaak links aan inhoud worden toegevoegd, zoals referenties, en dat van gebruikers niet wordt verwacht dat ze op elke link klikken die ze tegenkomen.

Toch twijfelen SEO's, zoals altijd, of het de moeite waard is om blindelings alles te geloven wat Google zegt, en te blijven experimenteren. Dus hebben de jongens van Ahrefs een onderzoek uitgevoerd om te controleren of de positie van een pagina op een SERP verband houdt met het aantal backlinks van pagina's met veel verkeer. Uit het onderzoek blijkt dat er nauwelijks sprake is van een verband. Bovendien bleken sommige hooggeplaatste pagina’s helemaal geen backlinks te hebben van pagina’s die rijk zijn aan verkeer.

Deze studie wijst ons in dezelfde richting als de woorden van John Mueller: je hoeft geen verkeer genererende backlinks naar je pagina te bouwen om hoge posities op een SERP te krijgen. Aan de andere kant heeft extra verkeer nog nooit enige schade aan een website toegebracht. De enige boodschap hier is dat backlinks die rijk zijn aan verkeer geen invloed lijken te hebben op de Google-ranglijst.

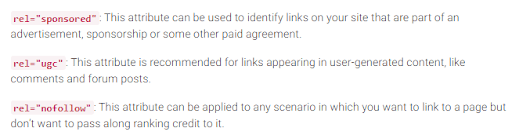

Zoals u zich herinnert, heeft Google in 2005 de nofollow- tag geïntroduceerd als een manier om linkspam te bestrijden. Is er vandaag iets veranderd? Eigenlijk ja.

Ten eerste heeft Google onlangs nog twee typen nofollow-attribuut geïntroduceerd. Voordien stelde Google voor om alle backlinks waaraan u niet wilt deelnemen aan de PageRank-berekening als nofollow te markeren, of het nu gaat om blogcommentaren of betaalde advertenties. Tegenwoordig raadt Google aan om rel="sponsored" te gebruiken voor betaalde links en partnerlinks en rel="ugc" voor door gebruikers gegenereerde inhoud.

Het is interessant dat deze nieuwe tags niet verplicht zijn (althans nog niet), en Google wijst erop dat je niet alle rel=”nofollow” handmatig hoeft te wijzigen in rel="sponsored" en rel=”ugc”. Deze twee nieuwe attributen werken nu op dezelfde manier als een gewone nofollow- tag.

Ten tweede zegt Google nu dat de nofollow-tags, evenals de nieuwe, sponsored en ugc, worden behandeld als hints, in plaats van als richtlijn bij het indexeren van pagina's.

Naast inkomende links zijn er ook uitgaande links, dat wil zeggen links die verwijzen naar andere pagina's van de jouwe.

Veel SEO's zijn van mening dat uitgaande links van invloed kunnen zijn op de rankings, maar deze veronderstelling wordt behandeld als een SEO-mythe. Maar er is in dit verband een interessant onderzoek om naar te kijken.

Reboot Online voerde in 2015 een experiment uit en voerde het in 2020 opnieuw uit. Ze wilden uitzoeken of de aanwezigheid van uitgaande links naar pagina's met een hoge autoriteit de positie van de pagina op een SERP beïnvloedde. Ze creëerden 10 websites met artikelen van 300 woorden, allemaal geoptimaliseerd voor een niet-bestaand trefwoord: Phylandocic. Vijf websites hadden helemaal geen uitgaande links meer, en vijf websites bevatten uitgaande links naar bronnen met een hoge autoriteit. Als gevolg hiervan begonnen de websites met gezaghebbende uitgaande links de hoogste positie te bemachtigen, en namen de websites die helemaal geen links hadden de laagste posities in.

.png)

Aan de ene kant kunnen de resultaten van dit onderzoek ons vertellen dat uitgaande links de positie van pagina's beïnvloeden. Aan de andere kant is de zoekterm in het onderzoek gloednieuw en heeft de inhoud van de websites een thema rond medicijnen en drugs. De kans is dus groot dat de zoekopdracht is geclassificeerd als YMYL. En Google heeft vaak het belang van EAT voor YMYL-websites benadrukt. De outlinks kunnen dus heel goed als een EAT-signaal zijn behandeld, wat bewijst dat de pagina's feitelijk correcte inhoud hebben.

Wat betreft gewone zoekopdrachten (niet YMYL) heeft John Mueller vaak gezegd dat u niet bang hoeft te zijn om vanuit uw inhoud naar externe bronnen te linken, aangezien uitgaande links goed zijn voor uw gebruikers.

Bovendien kunnen uitgaande links ook gunstig zijn voor SEO, omdat Google AI er mogelijk rekening mee houdt bij het filteren van spam op internet. Omdat pagina's met spam weinig of geen uitgaande links bevatten. Ze linken naar de pagina's onder hetzelfde domein (als ze ooit aan SEO denken) of bevatten alleen betaalde links. Dus als u naar een aantal geloofwaardige bronnen linkt, laat u Google zien dat uw pagina geen spam bevat.

Er was ooit de mening dat Google je een handmatige straf zou kunnen geven als je te veel uitgaande links hebt, maar John Mueller zei dat dit alleen mogelijk is als de uitgaande links duidelijk deel uitmaken van een of ander linkuitwisselingsprogramma, en de website in het algemeen van slechte kwaliteit. Wat Google bedoelt met voor de hand liggend is eigenlijk een mysterie, dus houd rekening met gezond verstand, inhoud van hoge kwaliteit en elementaire SEO.

Zolang PageRank bestaat, zullen SEO’s zoeken naar nieuwe manieren om deze te manipuleren.

In 2012 was het waarschijnlijker dat Google handmatige acties vrijgaf voor linkmanipulatie en spam. Maar nu kan Google, met zijn goed opgeleide antispamalgoritmen, bepaalde spamachtige links negeren bij het berekenen van de PageRank, in plaats van de hele website in het algemeen te verlagen. Zoals John Mueller zei:

Willekeurige links die door de jaren heen zijn verzameld, zijn niet per se schadelijk. We zien ze ook al heel lang en kunnen al die rare stukjes webgraffiti van lang geleden negeren.

Dit geldt ook voor negatieve SEO wanneer uw backlinkprofiel wordt gecompromitteerd door uw concurrenten:

Over het algemeen houden we hier automatisch rekening mee en proberen we ze automatisch te negeren als we ze zien gebeuren. Voor het grootste deel vermoed ik dat dit redelijk goed werkt. Ik zie maar weinig mensen die daar daadwerkelijk problemen mee hebben. Dus ik denk dat dat meestal goed werkt. Met betrekking tot het afwijzen van deze links vermoed ik dat als dit slechts normale spam-links zijn die zomaar op uw website verschijnen, ik me daar niet al te veel zorgen over zou maken. Waarschijnlijk hebben we dat zelf bedacht.

Dit betekent echter niet dat u zich nergens zorgen over hoeft te maken. Als de backlinks van uw website te veel en te vaak worden genegeerd, heeft u nog steeds een grote kans op een handmatige actie. Zoals Marie Haynes zegt in haar advies over linkmanagement in 2021:

Handmatige acties zijn gereserveerd voor gevallen waarin een anderszins fatsoenlijke site onnatuurlijke links heeft die ernaar verwijzen op een schaal die zo groot is dat de algoritmen van Google deze niet gemakkelijk kunnen negeren.

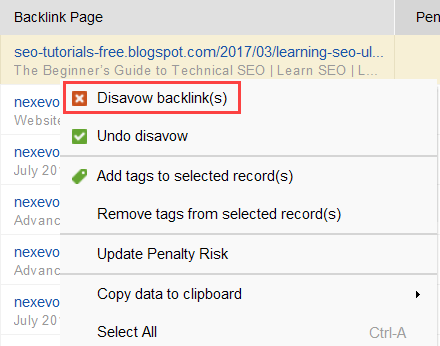

Om erachter te komen welke links het probleem veroorzaken, leest u deze handleiding over het controleren van de backlinkkwaliteit. Kortom, u kunt een backlinkchecker zoals SEO SpyGlass gebruiken. Ga in de tool naar het gedeelte Backlinkprofiel > Strafrisico. Besteed aandacht aan backlinks met een hoog en gemiddeld risico.

SEO SpyGlass downloadenOm verder te onderzoeken waarom deze of gene link als schadelijk wordt gerapporteerd, klikt u op het i- teken in de kolom Strafrisico. Hier zult u zien waarom de tool de link als slecht beschouwde en beslissen of u een link wel of niet zou afwijzen.

SEO SpyGlass downloadenAls u besluit een link van een groep links af te wijzen, klikt u er met de rechtermuisknop op en kiest u de optie Backlink(s) afwijzen:

Zodra u een lijst heeft samengesteld met links die u wilt uitsluiten, kunt u het disavow-bestand vanuit SEO SpyGlass exporteren en via GSC naar Google verzenden.

Over PageRank gesproken, we kunnen niet anders dan interne links noemen. De inkomende PageRank is iets waar we geen controle over hebben, maar we kunnen wel volledig bepalen hoe PR over de pagina's van onze website wordt verspreid.

Google heeft ook vaak het belang van interne links benadrukt. John Mueller onderstreepte dit nogmaals in een van de nieuwste Search Console Central hangouts. Een gebruiker vroeg hoe hij bepaalde webpagina's krachtiger kon maken. En John Mueller zei het volgende:

...Je kunt helpen met interne koppelingen. Binnen uw website kunt u dus echt de pagina's benadrukken die u meer onder de aandacht wilt brengen en ervoor zorgen dat ze intern echt goed gelinkt zijn. En misschien zijn de pagina's die je niet zo belangrijk vindt, zorg ervoor dat ze intern wat minder gelinkt zijn.

Intern linken betekent veel. Het helpt u de binnenkomende PageRank te delen tussen verschillende pagina's op uw website, waardoor uw slecht presterende pagina's worden versterkt en uw website in het algemeen sterker wordt.

Wat de benaderingen van interne links betreft, hebben SEO’s veel verschillende theorieën. Een populaire benadering heeft betrekking op de klikdiepte op websites. Dit idee houdt in dat alle pagina's op uw website zich op een afstand van maximaal 3 klikken van de startpagina moeten bevinden. Hoewel Google ook vaak het belang van een oppervlakkige websitestructuur heeft onderstreept, lijkt dit in werkelijkheid onbereikbaar voor alle groter dan kleine websites.

Nog een benadering is gebaseerd op het concept van gecentraliseerde en gedecentraliseerde interne koppeling. Zoals Kevin Indig het beschrijft:

Gecentraliseerde sites hebben één gebruikersstroom en trechter die naar één belangrijke pagina verwijst. Sites met gedecentraliseerde interne links hebben meerdere conversiecontactpunten of verschillende formaten voor aanmelding.

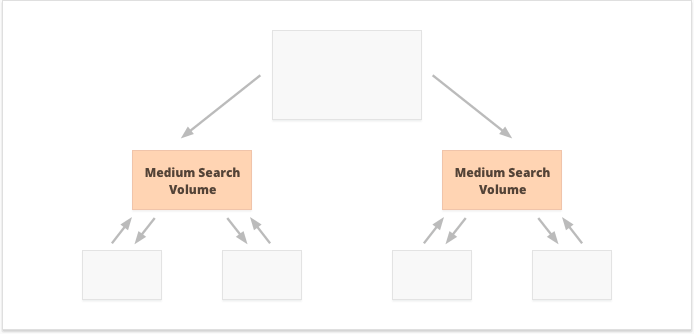

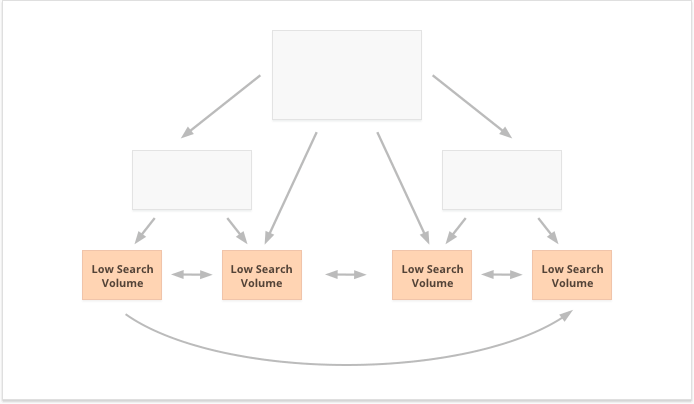

In het geval van gecentraliseerde interne links hebben we een kleine groep conversiepagina's of één pagina, die we krachtig willen maken. Als we gedecentraliseerde interne links toepassen, willen we dat alle websitepagina's even krachtig zijn en een gelijke PageRank hebben, zodat ze allemaal goed scoren voor uw zoekopdrachten.

Welke optie is beter? Het hangt allemaal af van de bijzonderheden van uw website en zakelijke niche, en van de zoekwoorden die u gaat targeten. Gecentraliseerde interne links passen bijvoorbeeld beter bij zoekwoorden met hoge en gemiddelde zoekvolumes, omdat dit resulteert in een beperkt aantal superkrachtige pagina's.

Long-tail-zoekwoorden met een laag zoekvolume zijn daarentegen beter voor gedecentraliseerde interne links, omdat PR gelijkmatig over talloze websitepagina's wordt verspreid.

Nog een aspect van succesvolle interne links is de balans tussen inkomende en uitgaande links op de pagina. In dit opzicht gebruiken veel SEO’s CheiRank (CR), wat eigenlijk een omgekeerde PageRank is. Maar terwijl PageRank de ontvangen kracht is, is CheiRank de weggegeven linkkracht. Nadat u PR en CR voor uw pagina's heeft berekend, kunt u zien welke pagina's linkafwijkingen vertonen, dat wil zeggen de gevallen waarin een pagina veel PageRank ontvangt, maar iets verder gaat, en omgekeerd.

Een interessant experiment hier is Kevin Indig's afvlakking van linkanomalieën. Er simpelweg voor zorgen dat de inkomende en uitgaande PageRank op elke pagina van de website in evenwicht is, leverde zeer indrukwekkende resultaten op. De rode pijl wijst hier naar het tijdstip waarop de afwijkingen zijn verholpen:

Linkafwijkingen zijn niet het enige dat de PageRank-stroom kan schaden. Zorg ervoor dat u niet vastloopt met technische problemen, die uw zuurverdiende PR teniet kunnen doen:

Weespagina's. Weespagina's zijn niet gelinkt aan een andere pagina op uw website, dus blijven ze gewoon inactief en ontvangen ze geen link-sap. Google kan ze niet zien en weet niet dat ze daadwerkelijk bestaan.

Omleidingsketens. Hoewel Google zegt dat omleidingen nu 100% van de PR passeren, wordt nog steeds aanbevolen om lange omleidingsketens te vermijden. Ten eerste slokken ze sowieso je crawlbudget op. Ten tweede weten we dat we niet blindelings alles kunnen geloven wat Google zegt.

Links in niet-parseerbaar JavaScript. Omdat Google ze niet kan lezen, passeren ze de PageRank niet.

404 koppelingen. 404-links leiden nergens toe, dus PageRank gaat ook nergens heen.

Links naar onbelangrijke pagina's. Natuurlijk kunt u geen van uw pagina's zonder links achterlaten, maar pagina's zijn niet gelijk. Als een pagina minder belangrijk is, is het niet rationeel om te veel moeite te doen om het linkprofiel van die pagina te optimaliseren.

Te verre pagina's. Als een pagina zich te diep op uw website bevindt, is de kans groot dat deze weinig of helemaal geen PR ontvangt. Omdat Google het misschien niet kan vinden en indexeren.

Om er zeker van te zijn dat uw website vrij is van deze PageRank-gevaren, kunt u deze controleren met WebSite Auditor. Deze tool heeft een uitgebreide set modules binnen de sectie Sitestructuur > Site-audit, waarmee u de algehele optimalisatie van uw website kunt controleren en uiteraard alle linkgerelateerde problemen kunt vinden en oplossen, zoals lange omleidingen:

Website Auditor downloadenen verbroken links:

Website Auditor downloadenAls u uw site wilt controleren op weespagina's of pagina's die te ver weg staan, schakelt u over naar Sitestructuur > Visualisatie:

Website Auditor downloadenDit jaar bestaat PageRank 23 jaar. En ik denk dat het ouder is dan sommige van onze huidige lezers:) Maar wat staat er in de toekomst voor PageRank te gebeuren? Zal het op een dag helemaal verdwijnen?

Wanneer ik een populaire zoekmachine probeer te bedenken die geen backlinks in hun algoritme gebruikt, is het enige idee dat ik kan bedenken het Yandex-experiment uit 2014. De zoekmachine kondigde aan dat het verwijderen van backlinks uit hun algoritme uiteindelijk linkspammers zou kunnen stoppen van manipulaties en hun inspanningen zou kunnen richten op het maken van kwaliteitswebsites.

Het kan een oprechte poging zijn geweest om naar alternatieve rankingfactoren te streven, of gewoon een poging om de massa ervan te overtuigen linksspam te laten vallen. Maar in ieder geval bevestigde Yandex binnen een jaar na de aankondiging dat de backlink-factoren weer in hun systeem zaten.

Maar waarom zijn backlinks zo onmisbaar voor zoekmachines?

Hoewel er talloze andere datapunten zijn om de zoekresultaten te herschikken nadat ze zijn begonnen te tonen (zoals gebruikersgedrag en BERT-aanpassingen), blijven backlinks een van de meest betrouwbare autoriteitscriteria die nodig zijn om de initiële SERP te vormen. Hun enige concurrent hier zijn waarschijnlijk entiteiten.

Zoals Bill Slawski het stelt wanneer hem wordt gevraagd naar de toekomst van PageRank:

Google onderzoekt machine learning en feitenextractie en begrijpt belangrijke waardeparen voor bedrijfsentiteiten, wat een beweging in de richting van semantisch zoeken betekent en een beter gebruik van gestructureerde gegevens en gegevenskwaliteit.

Toch heeft Google er weinig moeite mee om iets weg te gooien waar ze tientallen jaren aan ontwikkeling in hebben geïnvesteerd.

Google is erg goed in linkanalyse, wat inmiddels een zeer volwassen webtechnologie is. Daarom is het heel goed mogelijk dat PageRank gebruikt zal blijven om organische SERP’s te rangschikken.

Een andere trend waar Bill Slawski op wees was nieuws en andere kortstondige soorten zoekresultaten:

Google heeft ons verteld dat het minder afhankelijk is van PageRank voor pagina's waar actualiteit belangrijker is, zoals realtime resultaten (zoals van Twitter), of van nieuwsresultaten, waar actualiteit erg belangrijk is.

Een stukje nieuws leeft inderdaad veel te weinig in de zoekresultaten om voldoende backlinks te verzamelen. Google heeft dus gewerkt en zal mogelijk blijven werken aan het vervangen van backlinks door andere rankingfactoren bij het omgaan met nieuws.

Op dit moment worden de nieuwsranglijsten echter in hoge mate bepaald door de niche-autoriteit van de uitgever, en we lezen autoriteit nog steeds als backlinks:

"Gezaghebbendheidssignalen helpen bij het prioriteren van informatie van hoge kwaliteit uit de meest betrouwbare bronnen die beschikbaar zijn. Om dit te doen, zijn onze systemen ontworpen om signalen te identificeren die kunnen helpen bepalen welke pagina's blijk geven van expertise, gezaghebbendheid en betrouwbaarheid over een bepaald onderwerp, op basis van feedback van zoekbeoordelaars Deze signalen kunnen onder meer zijn of andere mensen de bron waarderen voor soortgelijke vragen of dat andere prominente websites over het onderwerp naar het verhaal linken.'

Last but not least was ik behoorlijk verrast door de moeite die Google heeft gedaan om gesponsorde en door gebruikers gegenereerde backlinks te kunnen identificeren en deze te onderscheiden van andere nofollow-links.

Als al deze backlinks moeten worden genegeerd, waarom zou u dan de een van de ander willen onderscheiden? Vooral nu John Muller suggereert dat Google later zou kunnen proberen dit soort links anders te behandelen.

Mijn wildste gok hier was dat Google misschien aan het valideren is of advertenties en door gebruikers gegenereerde links een positief rankingsignaal kunnen worden.

Voor adverteren op populaire platforms zijn immers enorme budgetten nodig, en enorme budgetten zijn een kenmerk van een groot en populair merk.

Door gebruikers gegenereerde inhoud gaat, wanneer deze buiten het spam-paradigma voor reacties wordt beschouwd, over echte klanten die hun echte steunbetuigingen geven.

De experts met wie ik contact opnam, geloofden echter niet dat dit mogelijk was:

Ik betwijfel of Google gesponsorde links ooit als een positief signaal zou beschouwen.

Het idee hier lijkt te zijn dat Google, door verschillende soorten links te onderscheiden, zou proberen erachter te komen welke van de nofollow-links moeten worden gevolgd voor doeleinden van het opbouwen van entiteiten:

Google heeft geen probleem met door gebruikers gegenereerde inhoud of gesponsorde inhoud op een website, maar beide zijn historisch gezien gebruikt als methoden om de pagerank te manipuleren. Als zodanig worden webmasters aangemoedigd om een nofollow-attribuut op deze links te plaatsen (naast andere redenen om nofollow te gebruiken). Nofollow-links kunnen echter nog steeds nuttig zijn voor Google voor bepaalde zaken (zoals entiteitsherkenning bijvoorbeeld), dus ze hebben eerder opgemerkt dat ze zou dit meer als een suggestie kunnen beschouwen, en niet als een richtlijn zoals een robots.txt-verbodsregel op uw eigen site. De verklaring van John Mueller was: "Ik kan me in onze systemen voorstellen dat we in de loop van de tijd zouden kunnen leren om ze iets anders te behandelen.” Dit zou kunnen verwijzen naar de gevallen waarin Google een nofollow als suggestie beschouwt. Hypothetisch gezien is het mogelijk dat de systemen van Google kunnen leren welke nofollow-links moeten worden gevolgd op basis van inzichten die zijn verzameld uit de typen links die zijn gemarkeerd als ugc en gesponsord. Nogmaals, dit zou niet veel invloed moeten hebben op de ranglijst van een site, maar het zou theoretisch ook een impact kunnen hebben op de site waarnaar wordt gelinkt.

Ik hoop echt dat ik de rol van backlinks in de huidige zoekalgoritmen van Google heb kunnen verduidelijken. Sommige gegevens die ik tegenkwam tijdens het onderzoek van het artikel waren zelfs voor mij een verrassing. Ik kijk er dus naar uit om deel te nemen aan uw discussie in de reacties.

Heeft u nog vragen die u nog onbeantwoord heeft? Heeft u ideeën over de toekomst van PageRank?